Para uma visão geral, analisamos os procedimentos da CHI: Conferência sobre Fatores Humanos em Sistemas de Computação por 10 anos e, com a ajuda da PNL e da análise de redes sociais, analisamos tópicos e áreas na interseção de disciplinas.

Na Rússia, o foco é especialmente forte nos problemas aplicados ao design de UX. Muitos dos eventos que ajudaram o crescimento do HCI no exterior não ocorreram em nosso país: o iSchools não apareceu , muitos especialistas envolvidos em aspectos relacionados à psicologia da engenharia deixaram a ciência etc. Como resultado, a profissão reapareceu, começando com problemas e pesquisas aplicados. Um dos resultados disso é visível até agora - é a representação extremamente baixa do trabalho de HCI russo nas principais conferências.

Mas fora da Rússia, a HCI se desenvolveu de maneiras muito diferentes, concentrando-se em uma variedade de tópicos e áreas. No programa de mestrado " Sistemas de informação e interação homem-computador”No HSE de São Petersburgo, discutimos, entre outras coisas, com estudantes, colegas, graduados de especialidades semelhantes de universidades europeias, parceiros que ajudam a desenvolver o programa, o que pertence ao campo da interação humano-computador. E essas discussões mostram a heterogeneidade da direção em que cada especialista tem sua própria imagem incompleta do campo.

De tempos em tempos, ouvimos perguntas sobre como essa direção está relacionada (e se está conectada) ao aprendizado de máquina e análise de dados. Para respondê-las, recorremos à pesquisa recente apresentada na conferência da CHI .

Antes de tudo, informaremos o que está acontecendo em áreas como xAI e iML (Inteligência Artificial eXplainable e Aprendizado de Máquina Interpretável) do lado das interfaces e dos usuários, bem como na IHC estudam os aspectos cognitivos do trabalho dos cientistas de dados, e daremos exemplos de trabalhos interessantes nos últimos anos em cada área.

xAI e iML

As técnicas de aprendizado de máquina estão passando por intenso desenvolvimento e - mais importante do ponto de vista da área em discussão - estão sendo ativamente implementadas na tomada de decisões automatizada. Portanto, os pesquisadores estão discutindo cada vez mais as seguintes perguntas: como os usuários que não aprendem a máquina interagem com sistemas em que algoritmos semelhantes são usados? Uma das questões importantes dessa interação: como fazer com que os usuários confiem nas decisões tomadas pelos modelos? Portanto, a cada ano, os tópicos de aprendizado de máquina interpretado (Interpretable Machine Learning - iML) e inteligência artificial explicável (eXplainable Artificial Intelligence - XAI) estão ficando mais quentes.

Ao mesmo tempo, se em conferências como NeurIPS, ICML, IJCAI, KDD, forem discutidos os algoritmos e os meios de iML e XAI, o CHI se concentrará em vários tópicos relacionados aos recursos de design e experiência de uso desses sistemas. Por exemplo, no CHI-2020, várias seções foram dedicadas a esse tópico de uma só vez, incluindo “IA / ML e observação através da caixa preta” e “Lidar com a AI: não novamente!”. Mas mesmo antes do surgimento de seções separadas, havia muitos desses trabalhos. Identificamos quatro áreas nelas.

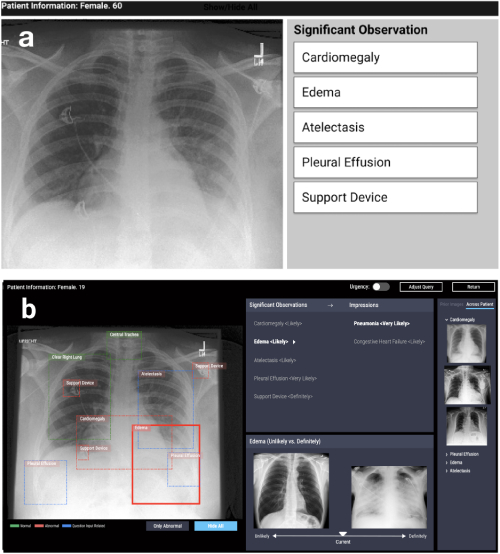

Projeto de sistemas interpretativos para resolver problemas aplicados

A primeira direção é o design de sistemas baseados em algoritmos de interpretabilidade em vários problemas aplicados: médico, social etc. Esses trabalhos surgem em áreas muito diferentes. Por exemplo, trabalhando no CHI-2020 CheXplain: permitindo que os médicos explorem e compreendam a análise de imagens médicas baseada em dados e habilitada para IA descreve um sistema que ajuda os médicos a examinar e explicar os resultados de radiografia de tórax. Ela oferece explicações textuais e visuais adicionais, além de imagens com o mesmo resultado e oposto (exemplos de apoio e conflito). Se o sistema predizer que uma doença é visível no raio-x, mostrará dois exemplos. O primeiro exemplo de suporte é um instantâneo dos pulmões de outro paciente que confirmou a mesma doença. O segundo exemplo contraditório é um instantâneo em que não há doença, ou seja, um instantâneo dos pulmões de uma pessoa saudável. A idéia principal é reduzir erros óbvios e reduzir o número de consultas externas em casos simples, a fim de agilizar o diagnóstico.

CheXpert: seleção automatizada de região + exemplos (improvável vs definitivamente)

Desenvolvendo sistemas para pesquisar modelos de aprendizado de máquina

A segunda direção é o desenvolvimento de sistemas que ajudam a comparar interativamente ou combinar vários métodos e algoritmos. Por exemplo, no trabalho de Silva: Avaliando interativamente a justiça do aprendizado de máquina usando a causalidade no CHI-2020, foi apresentado um sistema que constrói vários modelos de aprendizado de máquina nos dados do usuário e oferece a possibilidade de sua análise subsequente. A análise inclui a construção de um gráfico causal entre variáveis e o cálculo de várias métricas que avaliam não apenas a precisão, mas também a imparcialidade do modelo (Diferença de Paridade Estatística, Diferença de Oportunidade Igual, Diferença de Probabilidade Média, Impacto Disparado, Índice de Theil), o que ajuda a encontrar tendências. em previsões.

Silva : gráfico de relações entre variáveis + gráficos para comparar métricas de justiça + destaque de cores de variáveis influentes em cada grupo

Questões gerais de interpretabilidade do modelo

A terceira área é a discussão de abordagens para o problema da interpretabilidade dos modelos em geral. Na maioria das vezes, são críticas, críticas a abordagens e perguntas em aberto: por exemplo, o que se entende por "interpretabilidade". Aqui, gostaria de observar a revisão no CHI-2018 Tendências e trajetórias para sistemas explicáveis, responsáveis e inteligentes: uma agenda de pesquisa do HCI, em que os autores revisaram 289 artigos importantes sobre explicações em inteligência artificial e 12.412 publicações citando-os. Utilizando análise de rede e modelagem temática, eles identificaram quatro áreas-chave de pesquisa: 1) Sistemas inteligentes e ambientais (I&A); 2) IA explicável: algoritmos justos, responsáveis e transparentes (FAT) e Interpretable Machine Learning (iML); 3) teorias de Explicações: Causalidade e Psicologia Cognitiva, 4) Interatividade e Aprendizagem. Além disso, os autores descreveram as principais tendências de pesquisa: aprendizado interativo e interação com o sistema.

Pesquisa de usuário

Finalmente, a quarta área é a pesquisa de usuários sobre algoritmos e sistemas que interpretam modelos de aprendizado de máquina. Em outras palavras, esses estudos estudam se, na prática, novos sistemas estão se tornando mais claros e transparentes, quais são as dificuldades que os usuários enfrentam ao trabalhar com modelos interpretativos em vez de originais, como determinar se o sistema está sendo usado como planejado (ou se foi encontrada uma nova aplicação para ele) - talvez incorreto), quais são as necessidades dos usuários e se os desenvolvedores oferecem a eles o que realmente precisam.

Existem muitas ferramentas e algoritmos de interpretação, então surge a pergunta: como entender qual algoritmo escolher? Ao questionar a IA: informando práticas de design para experiências explicativas do usuário da IAsão discutidas as questões de motivação para o uso de algoritmos explicativos e são identificados problemas que, com toda a variedade de métodos, ainda não foram suficientemente resolvidos. Os autores chegaram a uma conclusão inesperada: a maioria dos métodos existentes é construída de forma a responder à pergunta "por que" ("por que tive esse resultado"), enquanto os usuários também precisam de uma resposta para a pergunta "por que não" ("por que não outro ") e, às vezes," o que fazer para alterar o resultado ".

O documento também diz que os usuários precisam entender quais são os limites de aplicabilidade dos métodos, quais limitações eles têm - e isso precisa ser explicitamente implementado nas ferramentas propostas. Esse problema é mostrado mais claramente no artigoInterpretando Interpretabilidade: Entendendo o Uso de Ferramentas de Interpretabilidade por Cientistas de Dados para Aprendizado de Máquina . Os autores realizaram um pequeno experimento com especialistas na área de aprendizado de máquina: eles mostraram os resultados de várias ferramentas populares para interpretar modelos de aprendizado de máquina e pediram que respondessem perguntas relacionadas à tomada de decisões com base nesses resultados. Acontece que mesmo os especialistas confiam demais nesses modelos e não levam os resultados criticamente. Como qualquer ferramenta, os modelos explicativos podem ser mal utilizados. Ao desenvolver o kit de ferramentas, é importante levar isso em conta, usando o conhecimento acumulado (ou especialistas) no campo da interação humano-computador, a fim de levar em consideração as características e necessidades dos usuários em potencial.

Data Science, Notebooks, Visualization

Outra área interessante do HCI está na análise dos aspectos cognitivos do trabalho com dados. Recentemente, a ciência levantou a questão de como os "graus de liberdade" do pesquisador - os recursos de coleta de dados, desenho experimental e escolha de métodos analíticos - afetam os resultados da pesquisa e sua reprodutibilidade. Embora grande parte da discussão e crítica esteja relacionada à psicologia e às ciências sociais, muitas questões dizem respeito à confiabilidade das conclusões no trabalho dos analistas de dados em geral, bem como às dificuldades em comunicar essas descobertas aos consumidores da análise.

Portanto, o assunto desta área de HCI é o desenvolvimento de novas maneiras de visualizar incertezas nas previsões de modelos, a criação de sistemas para comparar análises realizadas de diferentes maneiras, bem como a análise do trabalho dos analistas com ferramentas como os notebooks Jupyter.

Visualizando a incerteza

A visualização da incerteza é um dos recursos que distinguem os gráficos científicos da apresentação e da visualização de negócios. Por um longo período de tempo, o princípio do minimalismo e o foco nas principais tendências foram considerados a chave nesta última. No entanto, isso leva ao excesso de confiança dos usuários em uma estimativa pontual de magnitude ou previsão, o que pode ser crítico, especialmente se tivermos que comparar previsões com diferentes graus de incerteza. A incerteza do trabalho é exibida usando Dotplots ou CDFs quantílicos, melhorando a tomada de decisões de trânsitoexamina como a visualização da incerteza na previsão de gráficos de dispersão e funções de distribuição cumulativa ajuda os usuários a tomar decisões mais racionais usando o exemplo do problema de estimar a hora de chegada de um ônibus a partir dos dados de um aplicativo móvel. O que é especialmente interessante é que um dos autores mantém o pacote ggdist para R com várias opções para visualizar a ambiguidade.

Exemplos de visualização de incerteza ( https://mjskay.github.io/ggdist/ )

No entanto, geralmente há problemas para visualizar possíveis alternativas, por exemplo, para seqüências de ação do usuário em análises da web ou análises de aplicativos. O trabalho visualizando incertezas e alternativas nas previsões de sequência de eventos analisa como uma representação gráfica das alternativas com base no modelo de Rede Neural Recorrente com Reconhecimento de Tempo (TRNN ) ajuda os especialistas a tomar decisões e confiar nelas.

Comparação de modelos

Tão importante quanto visualizar a incerteza, um aspecto do trabalho dos analistas é comparar como - muitas vezes oculta - a escolha do pesquisador de diferentes abordagens para modelagem em todos os seus estágios pode levar a diferentes resultados analíticos. Na psicologia e nas ciências sociais, o pré-registro do desenho da pesquisa e uma clara separação dos estudos exploratórios e confirmatórios estão ganhando popularidade. No entanto, em tarefas nas quais a pesquisa é mais orientada por dados, uma alternativa pode ser uma ferramenta que permita avaliar os riscos ocultos da análise, comparando modelos. Trabalhando Aumentando a Transparência dos Documentos de Pesquisa com Análises Multiversas Exploráveissugere o uso de visualização interativa de várias abordagens de análise em artigos. Em essência, o artigo se transforma em um aplicativo interativo, onde o leitor pode avaliar o que mudará nos resultados e nas conclusões se uma abordagem diferente for aplicada. Parece uma ideia útil também para análises práticas.

Trabalhando com ferramentas para organizar e analisar dados

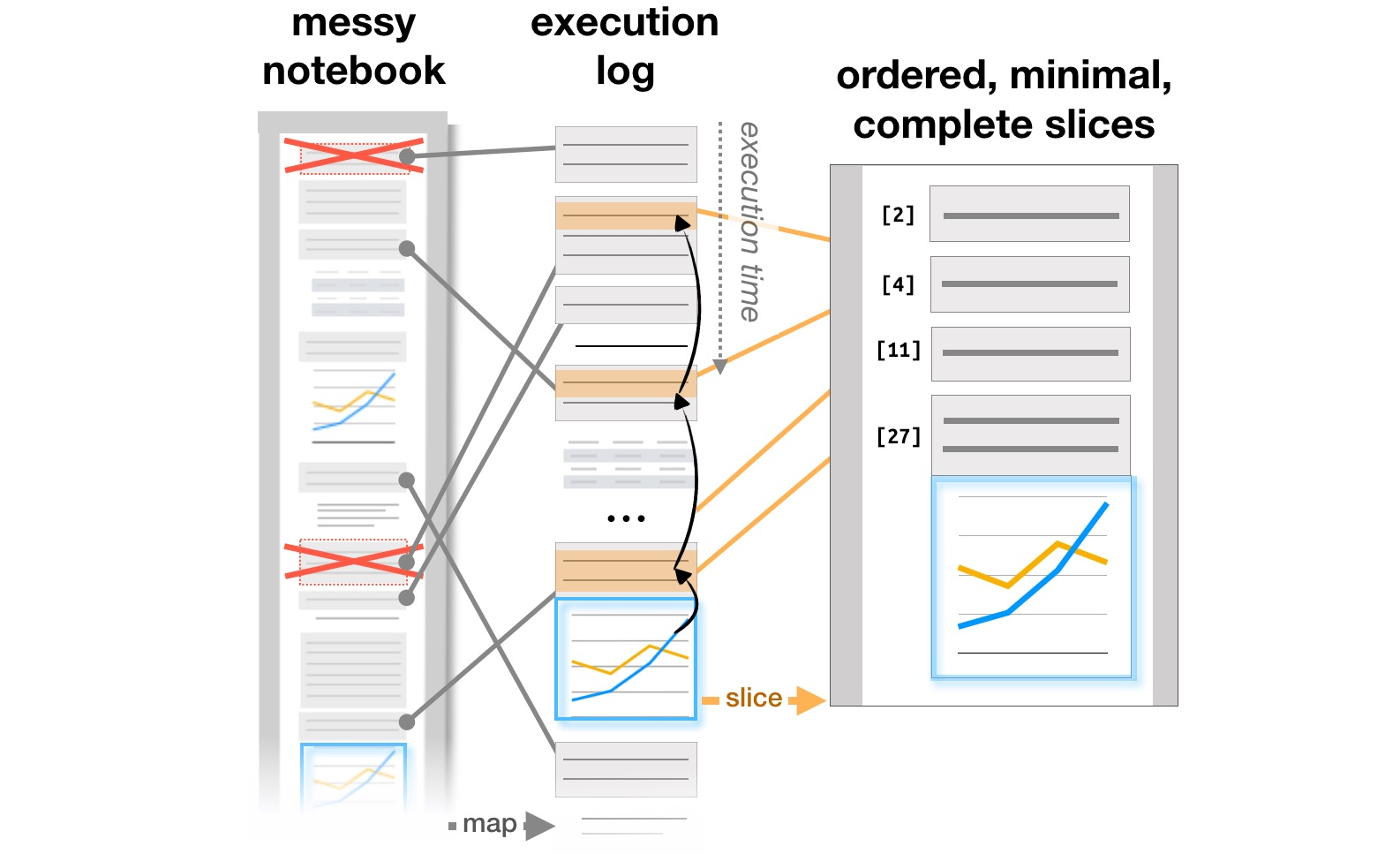

O último bloco de trabalho está relacionado ao estudo de como os analistas trabalham com sistemas como o Jupyter Notebooks, que se tornaram uma ferramenta popular para organizar a análise de dados. O artigo Exploração e explicação em notebooks computacionais analisa as contradições entre a pesquisa e explica os objetivos de aprendizado encontrados nos documentos interativos do Github e sobre gerenciamento de mensagens em notebooks computacionaisos autores analisam como as notas, partes do código e visualizações evoluem em um fluxo de trabalho de analista iterativo e sugerem possíveis adições a ferramentas para apoiar esse processo. Finalmente, já no CHI 2020, os principais problemas dos analistas em todas as etapas do trabalho, desde o carregamento de dados até a transferência de um modelo para a produção, bem como idéias para aprimorar ferramentas, estão resumidos no artigo O que há de errado com os notebooks computacionais? Pontos problemáticos, necessidades e oportunidades de design .

Transformação da estrutura de relatórios com base em logs de execução ( https://microsoft.github.io/gather/ )

Resumindo

Concluindo a parte da discussão "o que a HCI faz" e "por que um especialista em HCI conhece o aprendizado de máquina", gostaria de reiterar a conclusão geral da motivação e dos resultados desses estudos. Assim que uma pessoa aparece no sistema, isso imediatamente leva a uma série de perguntas adicionais: como simplificar a interação com o sistema e evitar erros, como o usuário altera o sistema, se o uso real difere do planejado. Como resultado, precisamos daqueles que entendem como o processo de projetar sistemas com inteligência artificial funciona e sabem como levar em consideração o fator humano.

Ensinamos tudo isso no programa de mestrado " Sistemas de informação e interação homem-computador" Se você estiver interessado na pesquisa da HCI, confira a luz (a campanha de admissões está apenas começando ). Ou siga o nosso blog: falaremos mais sobre os projetos em que os alunos estão trabalhando este ano.