50 anos de história das placas de vídeo (1970-2020): Uma história completa das placas de vídeo e seus progenitores

Parte 1

Gráficos de computador. Ao ouvir essas palavras, apresentamos efeitos especiais impressionantes de grandes sucessos de bilheteria, belos modelos de personagens de jogos AAA e tudo o que tem a ver com a beleza visual da tecnologia moderna. Mas a computação gráfica, como qualquer aspecto tecnológico, vem se desenvolvendo há mais de uma década, tendo superado o caminho da exibição de vários símbolos em uma tela monocromática para paisagens e heróis incríveis, a cada ano cada vez mais difícil de distinguir da realidade. Hoje começaremos uma história sobre como começou a história da computação gráfica, lembrando como surgiu o termo "placa de vídeo" e a abreviatura de GPU, e quais barreiras técnicas os líderes de mercado superaram ano após ano em um esforço para conquistar um novo público.

Prefácio da época. O nascimento dos computadores (anos 1940/1950)

A era da tecnologia da computação, muitos associam com o início da era dos computadores pessoais no início dos anos 80, mas na verdade, os primeiros computadores apareceram muito antes. O primeiro desenvolvimento de tais máquinas começou antes da Segunda Guerra Mundial, e protótipos, vagamente uma reminiscência de futuros PCs, foram lançados já em 1947. O primeiro dispositivo desse tipo foi o IBM 610, um computador experimental desenvolvido por John Lenz do Laboratório Watson da Columbia University. Foi o primeiro na história a receber o orgulhoso nome de "Personal Automatic Computer" (PAC), embora tenha sido um pouco exagerado - a máquina custou US $ 55.000 e apenas 150 cópias foram feitas.

Os primeiros sistemas visuais impressionantes surgiram nos mesmos anos. Já em 1951, a IBM, com a participação da General Electric e uma série de empreiteiros militares, desenvolveu um simulador de vôo para as necessidades do exército. Ele usava a tecnologia de virtualização tridimensional - o piloto, que estava por trás do simulador, viu a projeção da cabine e poderia atuar como faria nos controles de um avião real. Mais tarde, o protótipo gráfico foi usado por Evans & Sutherland, que criaram um simulador piloto CT5 completo, baseado em uma série de computadores DEC PDP-11. Pense só - ainda estamos nos anos 50 e já tínhamos gráficos tridimensionais!

1971-1972. Magnavox Odyssey e PONG

O boom da tecnologia de semicondutores e a fabricação de microcircuitos mudou completamente o equilíbrio de poder no mercado, antes pertencente a computadores analógicos volumosos que ocupavam corredores inteiros. Afastando-se dos tubos de vácuo e dos cartões perfurados, a indústria entrou na era do entretenimento familiar, apresentando ao mundo ocidental os "sistemas de videogame doméstico", as bisavós dos consoles modernos.

Um pioneiro no entretenimento de videogame foi um dispositivo chamado Odyssey Magnavox, o primeiro sistema de jogo lançado oficialmente. O Odyssey tinha controladores estranhos para os padrões modernos, e todo o sistema gráfico exibia apenas uma linha e dois pontos na tela da TV, que eram controlados pelos jogadores. Os criadores do aparelho abordaram o assunto com imaginação, e o console veio com sobreposições coloridas especiais na tela que poderiam "pintar" os mundos de jogo de diversos projetos que acompanham o Odyssey. Um total de 28 jogos foram lançados para o dispositivo, entre os quais um pingue-pongue aparentemente simples, que inspirou entusiastas da jovem empresa Atari a lançar uma máquina caça-níqueis chamada Pong com um jogo idêntico. Foi Pong que se tornou o início da magia das caça-níqueis, que, aliás, conquistou completamente o Japão e o mundo ocidental no início dos anos 80.

Apesar de sua óbvia simplicidade, a Magnavox Odyssey usava cartuchos reais - embora de muitas maneiras apenas para efeito. Não havia chips de memória neles - os cartuchos serviam como um conjunto de jumpers, transformando magicamente um arranjo de uma linha com pontos em outro, mudando assim o jogo. O set-top box primitivo estava longe de ser um chip de vídeo completo, mas a popularidade do Magnavox Odyssey mostrou um claro interesse do público, e muitas empresas começaram a desenvolver seus próprios dispositivos, sentindo o potencial de lucro.

1976-1977. Fairchild Channel F e Atari 2600

Não demorou muito para esperar pela primeira batalha séria para o mercado de jogos recém-nascido. Em 1975, o envelhecimento rápido Magnavox Odyssey desapareceu das prateleiras, e em seu lugar dois dispositivos lutaram pelo título de melhor console da nova geração - Canal F da Fairchild e Atari VCS da mesma empresa que deu ao mundo Pong.

Apesar do desenvolvimento dos consoles ocorrer quase simultaneamente, a Atari não teve tempo - e a Fairchild foi a primeira a lançar seu aparelho chamado Fairchild Video Entertainment System (VES).

O console Fairchild chegou às prateleiras das lojas em novembro de 1976 e é um tesouro de qualidades técnicas. Em vez de controladores Odyssey indistintos, apareceram outros confortáveis, cartuchos falsos foram substituídos por reais (dentro dos quais havia chips ROM com dados de jogo) e um alto-falante foi instalado dentro do console que reproduzia sons e músicas de um jogo em execução. O anexo foi capaz de desenhar uma imagem usando uma paleta de 8 cores (no modo de linha preto-e-branco ou cor) com uma resolução de 102x54 pixels. Separadamente, deve-se notar que o processador Fairchild F8 instalado no sistema VES foi desenvolvido por Robert Noyce, que em 1968 fundou uma pequena mas promissora empresa Intel.

A Atari estava à beira do desespero - o projeto Stella, a base do futuro console, estava muito atrasado em termos de desenvolvimento, e o mercado, como você sabe, não vai esperar. Muitas coisas que pareciam inovadoras com o lançamento do Fairchild VES estavam prestes a se tornar uma parte integrante de todos os futuros consoles. Percebendo que tudo está em jogo, o fundador da Atari, Nolan Bushnell, assina um acordo com a Warner Communications, vendendo sua ideia por US $ 28 milhões, com a condição de que o console Atari chegue ao mercado o mais rápido possível.

Warner não decepcionou, e o trabalho no console começou a ferver com vigor renovado. Para simplificar a lógica e reduzir o custo de produção, o famoso engenheiro Jay Miner esteve envolvido no desenvolvimento, que retrabalhou os chips de saída de vídeo e processamento de áudio TIA (Adaptador de Interface de Televisão) em um único elemento, que foi o toque final antes que o console estivesse pronto. Para irritar Fairchild, os comerciantes da Atari nomearam o console VCS (Video Computer System), forçando o concorrente a renomear o Canal F.

Mas isso não ajudou o Canal F a competir com sucesso com o novo produto - embora na fase de lançamento do console em 1977 apenas 9 jogos estivessem prontos, os desenvolvedores rapidamente perceberam o início de uma nova era tecnológica e começaram a usar o poder do console ao máximo. O Atari VSC (mais tarde se tornaria o Atari 2600) foi o primeiro decodificador baseado em um chip complexo, não apenas processando vídeo e áudio, mas também comandos recebidos do joystick. As vendas modestas, que inicialmente embaraçaram a Warner, foram substituídas por um sucesso fenomenal após a decisão de licenciar o fliperama Space Invaders pela empresa japonesa Taito. Os cartuchos, inicialmente limitados a 4 KB de memória, eventualmente aumentaram para 32 KB, e o número de jogos chegou a centenas.

O segredo do sucesso da Atari está na lógica mais simplificada do dispositivo, a capacidade dos desenvolvedores de programar jogos de forma flexível usando 2600 recursos (por exemplo, ser capaz de mudar a cor do sprite enquanto desenha), bem como a atratividade externa e controladores convenientes chamados joysticks (do joystick literal - o stick da felicidade) ... Então, se você não sabia de onde veio o termo, você pode agradecer aos desenvolvedores do Atari por isso. Bem como para a imagem principal de todos os jogos retro - um alienígena engraçado de Space Invaders.

Depois que o sucesso do Atari 2600 foi além de todos os valores previstos, a Fairchild deixou o mercado de videogames, decidindo que a direção logo desapareceria. Provavelmente, a empresa ainda lamenta tal decisão.

1981-1986. A era do IBM PC.

Apesar de já em 1979 a Apple ter introduzido o Apple II, que mudou para sempre a imagem do computador acessível, o conceito de “computador pessoal” surgiu um pouco mais tarde e pertencia a uma empresa completamente diferente. A Monumental IBM, com décadas de mainframes pesados (ruído de bobina e luzes piscando), de repente deu um passo para o lado e criou um mercado que nunca existiu antes.

Em 1981, o lendário IBM PC foi colocado à venda, precedido por uma das melhores campanhas publicitárias da história do marketing. “Ninguém jamais foi demitido por comprar IBM”, dizia o mesmo slogan que ficará para sempre na história da publicidade.

No entanto, não foram apenas slogans e anúncios chamativos que fizeram o nome do computador pessoal IBM. Foi para ele que, pela primeira vez na história, um complexo sistema gráfico foi desenvolvido a partir de dois adaptadores de vídeo - um Monochrome Display Adapter (MDA) e um Color Graphics Adapter (CGA).

O MDA foi projetado para digitação com suporte para 80 colunas e 25 linhas na tela para caracteres ASCII com resolução de 720 × 350 pixels. O adaptador usava memória de vídeo 4K e exibia um texto verde em uma tela preta. Nesta modalidade, era fácil e cómodo trabalhar com equipas, documentos e demais tarefas quotidianas do sector empresarial.

O CGA, por outro lado, pode ser considerado um avanço em termos de recursos gráficos. O adaptador suportava uma paleta de 4 bits em uma resolução de 640x200 pixels, tinha 16 KB de memória e formava a base para o padrão de computação gráfica para a linha em expansão ativa de computadores IBM PC.

No entanto, havia sérias desvantagens em usar dois adaptadores de saída de vídeo diferentes. Muitos problemas técnicos possíveis, o alto custo dos dispositivos e uma série de outras limitações levaram os entusiastas a trabalhar em uma solução universal - um adaptador gráfico capaz de funcionar em dois modos simultaneamente. O primeiro produto desse tipo no mercado foi a Hercules Graphics Card (HGC), desenvolvida pela empresa de mesmo nome Hercules em 1984.

Placa Gráfica Hercules (HGC)

Segundo a lenda, o fundador da empresa Hercules, Van Suwannukul, desenvolveu um sistema especificamente para trabalhar em sua dissertação de doutorado em seu idioma nativo tailandês. O adaptador IBM MDA padrão não renderizou a fonte Thai corretamente, o que levou o desenvolvedor a começar a construir o HGC em 1982.

O suporte para 720x348 pixels para texto e gráficos, bem como a capacidade de trabalhar nos modos MDA e CGA, garantiu ao adaptador Hercules uma longa vida. O legado da empresa na forma de padrões universais de saída de vídeo HGC e HGC + foi usado por desenvolvedores de computadores compatíveis com a IBM e mais tarde uma série de outros sistemas até o final dos anos 90. No entanto, o mundo não parou e o rápido desenvolvimento da indústria de computadores (assim como sua parte gráfica) atraiu muitos outros entusiastas - entre eles estavam quatro migrantes de Hong Kong - Kwak Yuan Ho, Lee Lau, Francis Lau (Francis Lau) e Benny Lau (Benny Lau), que fundaram a Array Technology Inc - a empresa que o mundo inteiro reconhecerá como ATI Technologies Inc.

1986-1991. O primeiro boom no mercado de placas de vídeo. Sucessos iniciais da ATI

Após o lançamento do IBM PC, a IBM não permaneceu na vanguarda da tecnologia da computação por muito tempo. Já em 1984, Steve Jobs apresentou o primeiro Macintosh com uma interface gráfica impressionante e tornou-se óbvio para muitos que a tecnologia gráfica estava prestes a dar um salto real. Mas, apesar de perder a liderança do setor, a IBM se destacou da Apple e de outros concorrentes em sua visão. A filosofia de padrões abertos da IBM abriu a porta para qualquer dispositivo compatível, o que atraiu várias startups de seu tempo para o campo.

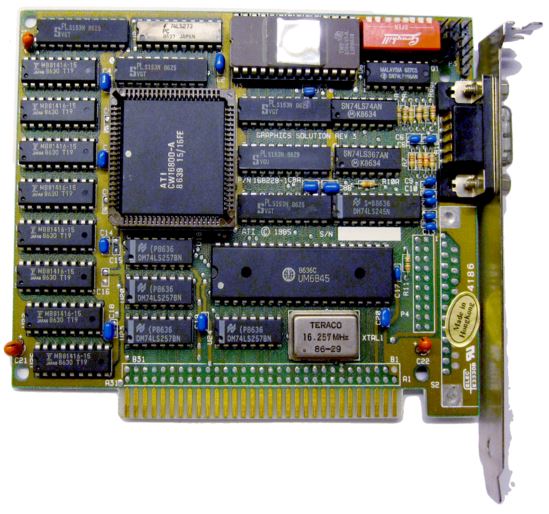

Entre eles estava a jovem empresa ATI Technologies. Em 1986, os especialistas de Hong Kong lançaram seu primeiro produto comercial, o OEM Color Emulation Card.

Cartão de emulação de cor

Expandindo os recursos dos controladores monocromáticos padrão, os engenheiros da ATI forneceram três cores de fontes em uma tela preta - verde, âmbar e branco. O adaptador tinha 16 KB de memória e provou fazer parte dos computadores Commodore. Em seu primeiro ano de vendas, o produto rendeu à ATI mais de US $ 10 milhões.

Claro, este foi apenas o primeiro passo para a ATI - depois da solução gráfica expandida com 64 KB de memória de vídeo e capacidade de trabalhar em três modos (MDA, CGA, EGA), a linha ATI Wonder entrou no mercado, com a aparência de que os padrões anteriores poderiam ser escritos em arcaísmos ...

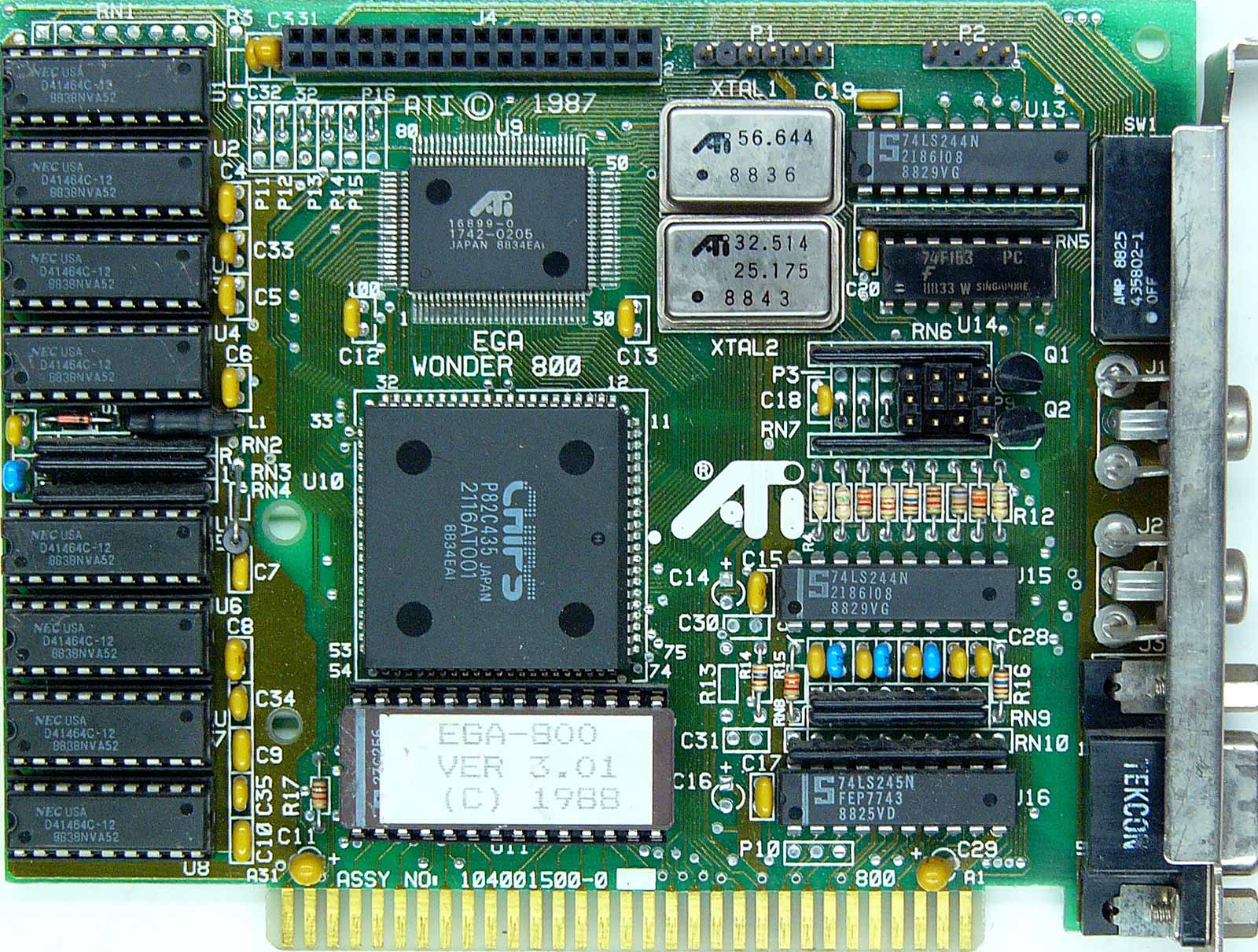

Parece muito ousado? Julgue por si mesmo - os adaptadores da série Wonder receberam um buffer de 256 KB de memória de vídeo (4 vezes mais!), E em vez de uma paleta de quatro cores, 16 cores foram exibidas na tela com uma resolução de 640x350. Ao mesmo tempo, não havia restrições ao trabalhar com vários formatos de saída - ATI Wonder emulou com sucesso qualquer um dos modos anteriores (MDA, CGA, EGA) e, começando com a 2ª série, recebeu suporte para o padrão Extend EGA mais recente.

ATi Wonder

O ponto culminante do desenvolvimento da linha em 1987 foi o famoso ATI EGA Wonder 800, que exibiu uma paleta de 16 cores já no formato VGA em uma resolução incrivelmente alta de 800x600. O adaptador foi vendido no formato mais acessível VGA Improved Performance Card (VIP) com suporte de saída VGA limitado.

O primeiro apogeu do mercado de placas de vídeo. Inovações ATI, o início da competição

O sucesso significativo da ATI no desenvolvimento de adaptadores gráficos comerciais atraiu a atenção de muitas outras empresas - de 1986 a 1987, marcas como Trident, SiS, Tamarack, Realtek, Oak Technology, LSI (G-2 Inc), Hualon, Cornerstone Imaging e Windbond. Além de novos rostos, os atuais representantes do Vale do Silício também se interessaram em entrar no mercado gráfico - empresas como AMD, Western Digital / Paradise Systems, Intergraph, Cirrus Logic, Texas Instruments, Gemini e Genoa - cada um deles apresentou de alguma forma o primeiro produto gráfico em o mesmo período de tempo.

Em 1987, a ATI entrou no mercado OEM como fornecedora da série de produtos Graphics Solution Plus. Esta linha foi projetada para funcionar com o barramento de 8 bits de computadores IBM PC / XT baseados na plataforma Intel 8086/8088. Os adaptadores GSP também suportavam os formatos de saída MDA, CGA e EGA, mas com a troca original entre eles na própria placa. O aparelho foi bem recebido no mercado, e mesmo um modelo semelhante da Paradise Systems com 256 KB de memória de vídeo (GSP tinha apenas 64 KB) não impediu a Ati de adicionar um novo produto de sucesso ao seu portfólio.

Nos próximos anos, a empresa canadense ATI Technologies Inc. permaneceu no auge da inovação gráfica, superando de forma consistente a concorrência. A então conhecida linha de adaptadores Wonder foi a primeira no mercado a mudar para cores de 16 bits; recebeu suporte para EVGA (nos adaptadores Wonder 480 e Wonder 800+) e SVGA (no Wonder 16). Em 1989, a ATI baixou os preços da linha Wonder 16 e adicionou um conector VESA para a capacidade de conectar dois adaptadores um ao outro - podemos dizer que essas foram as primeiras fantasias sobre pacotes de vários dispositivos que aparecerão no mercado muito mais tarde.

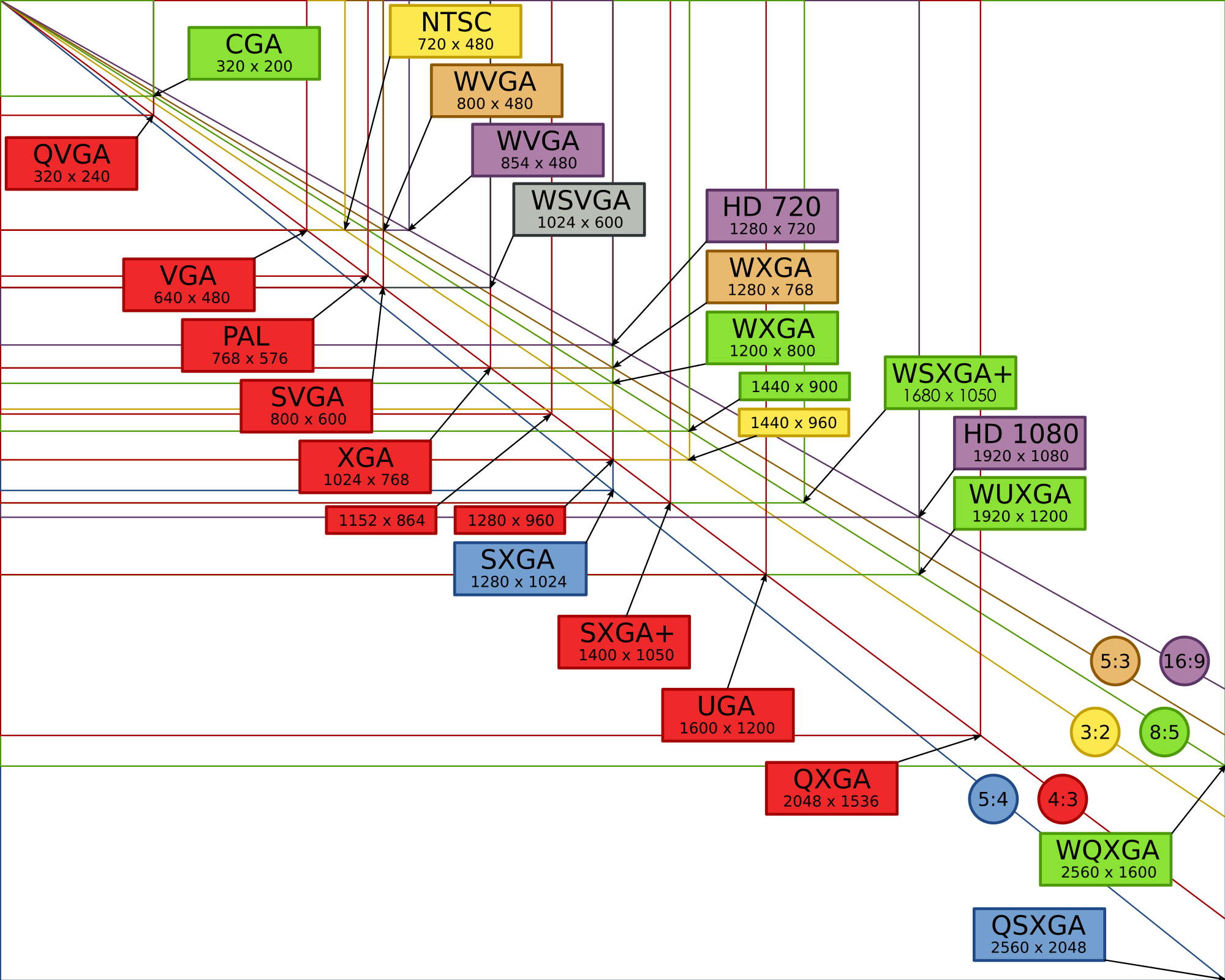

Devido à proliferação de um mercado com inúmeros formatos e fabricantes, uma organização dedicada foi necessária para regulamentá-los e desenvolver padrões-chave para os participantes do mercado. Em 1988, a VESA (Video Electronics Standard Association) foi fundada pelos esforços de seis fabricantes importantes, que assumiram a centralização de padrões e formatos de resolução, bem como a paleta de cores dos adaptadores gráficos. O primeiro formato era o SVGA (800x600 pixels), que já era usado nos cartões Ati Wonder 800. Mais tarde, havia mais deles, e alguns (incluindo HGC e HGC +) foram usados por décadas.

A liderança tecnológica da ATi continuou no início dos anos 1990. Em 1991, foi lançado o Wonder XL - o primeiro adaptador gráfico com suporte para 32 mil cores e suporte para resolução 800x600 com taxa de atualização de 60 Hz. Isso foi conseguido com o uso do conversor Sierra RAMDAC. Além disso, o Wonder XL se tornou o primeiro adaptador com 1 MB de memória de vídeo onboard.

Em maio do mesmo ano, a ATI lançou o Mach8, o primeiro produto em uma nova linha de Mach para lidar com operações 2D simples, como desenho de linha, preenchimento de cores e bitmap. Mach8 estava disponível para compra como um chip (para integração subsequente - por exemplo, em sistemas de negócios OEM) e como uma placa completa. Agora, muitos acharão estranho lançar um adaptador separado para essas coisas, mas 30 anos atrás, muitos cálculos especiais ainda dependiam do processador central, enquanto os adaptadores gráficos eram destinados a uma gama restrita de tarefas.

No entanto, esta forma de coisas não durou muito - seguindo o interessante VGA Stereo F / X, simbiose de um adaptador gráfico e placa Sound Blaster para emular um codec em formato mono em tempo real, o líder da indústria apresentou um produto para trabalhar com gráficos 2D e 3D - VGA Wonder GT. Ao combinar as capacidades do Mach8 e do Wonder Ati foram os primeiros a resolver o problema da necessidade de um adaptador adicional para trabalhar com diferentes tipos de tarefas. O lançamento do popular sistema operacional Windows 3.0, que pela primeira vez se concentrou em uma ampla gama de tarefas no trabalho com gráficos 2D, contribuiu para o sucesso significativo dos novos produtos. O Wonder GT estava em demanda entre os integradores de sistema, o que teve um efeito benéfico sobre os lucros da empresa - em 1991, o faturamento da ATI ultrapassou US $ 100 milhões. O futuro prometia ser brilhante, mas a concorrência no mercado nunca diminuiu - novos desafios aguardavam os líderes.

1992-1995. Desenvolvimento OpenGL. O segundo boom no mercado de placas de vídeo. Novas fronteiras em 2D e 3D

Em janeiro de 1992, a Silicon Graphics Inc. apresentou a primeira interface de programação multi-plataforma OpenGL 1.0, com suporte para gráficos 2D e 3D.

O futuro padrão aberto é baseado na biblioteca proprietária IRIS GL (Integrated Raster Imaging System Graphical Library, Biblioteca de sistema integrado para processamento de gráficos raster). Percebendo que em breve muitas empresas irão introduzir no mercado suas bibliotecas deste tipo, a SGI decidiu fazer do OpenGL um padrão aberto, compatível com qualquer plataforma do mercado. A popularidade dessa abordagem era difícil de superestimar - todo o mercado chamou a atenção para OpenGL.

Inicialmente, a Silicon Graphics era voltada para o mercado UNIX profissional, planejando tarefas específicas para uma futura biblioteca aberta, mas graças à sua disponibilidade para desenvolvedores e entusiastas, o OpenGL rapidamente conquistou um lugar no emergente mercado de jogos 3D.

No entanto, nem todos os principais participantes do mercado aceitaram essa abordagem SGI. Ao mesmo tempo, a Microsoft estava desenvolvendo sua própria biblioteca de software Direct3D e não tinha pressa em integrar o suporte OpenGL ao sistema operacional Windows.

O Direct3D foi abertamente criticado pelo famoso autor de Doom, John Carmack, que portou pessoalmente o Quake para o OpenGL para Windows, enfatizando as vantagens do código simples e compreensível de uma biblioteca aberta no contexto de uma versão complexa e "lixo" da Microsoft.

John Carmack

Mas a posição da Microsoft permaneceu inalterada e, após o lançamento do Windows 95, a empresa se recusou a licenciar o driver OpenGL MCD, graças ao qual o usuário poderia decidir de forma independente por meio de qual biblioteca iniciar um aplicativo ou um novo jogo. A SGI encontrou uma brecha ao lançar um driver Installable Client Driver (ICD), que, além da rasterização OpenGL, recebeu suporte para processamento de efeitos de iluminação.

O crescimento explosivo da popularidade do OpenGL levou ao fato de que a solução SGI se tornou popular no segmento de estações de trabalho, o que obrigou a Microsoft a dedicar todos os recursos possíveis para criar sua biblioteca proprietária no menor tempo possível. A base para a futura API foi fornecida pelo estúdio RenderMorphics, comprado em fevereiro de 1995, cuja biblioteca de software Reality Lab formou os princípios básicos do Direct3D.

O renascimento do mercado de placas de vídeo. A onda de fusões e aquisições

Mas vamos voltar um pouco ao passado. Em 1993, o mercado de placas de vídeo experimentou um renascimento e muitas novas empresas promissoras chamaram a atenção do público. Um deles foi a NVidia, fundada por Jensen Huang, Curtis Prahm e Chris Malakhovsky em janeiro de 1993. Huang, que trabalhava como engenheiro de software na LSI, há muito tempo tinha a ideia de abrir uma empresa de placas gráficas, e seus colegas na Sun Microsystems acabavam de trabalhar na arquitetura gráfica GX. Ao unir forças e arrecadar US $ 40.000, os três entusiastas lançaram uma empresa que estava destinada a desempenhar um papel fundamental no setor.

Jensen huang

No entanto, naqueles anos ninguém ousou olhar para o futuro - o mercado estava mudando rapidamente, novas APIs e tecnologias proprietárias apareciam quase todos os meses, e era óbvio que nem todos sobreviveriam no turbulento ciclo da competição. Muitas das empresas que entraram na corrida armamentista gráfica no final dos anos 1980 foram forçadas a declarar falência, incluindo Tamerack, Gemini Technology, Genoa Systems e Hualon, enquanto a Headland Technology foi adquirida pela SPEA, e Acer, Motorola e Acumos tornaram-se propriedade Cirrus Logic.

Como você deve ter adivinhado, a ATI se destacou neste cluster de fusões e aquisições. Os canadenses continuaram a trabalhar duro e a produzir produtos inovadores de qualquer maneira - mesmo que tenha ficado muito mais difícil.

Em novembro de 1993, a ATI lançou a placa de captura de vídeo VideoIt! que era baseado no chip decodificador 68890, capaz de gravar um sinal de vídeo em uma resolução de 320x240 a 15 quadros por segundo ou 160x120 a 30 quadros por segundo. Graças à integração do chip VCP Intel i750Pd, o dono da novidade poderia realizar compressão-descompressão do sinal de vídeo em tempo real, o que era especialmente útil ao trabalhar com grandes quantidades de dados. VideoIt! o primeiro no mercado foi ensinado a usar o barramento central para se comunicar com o acelerador gráfico, e nenhum cabo e conector foi necessário como antes.

Problemas de ATI e sucessos do S3 Graphics

Para a ATI, 1994 foi um verdadeiro teste - devido à séria competição, a empresa teve perdas de US $ 4,7 milhões. A principal causa de problemas para os desenvolvedores canadenses foi o sucesso do S3 Graphics. O acelerador gráfico S3 Vision 968 e o adaptador Trio64 garantiram uma dúzia de importantes contratos OEM com líderes de mercado como Dell, HP e Compaq para a empresa de desenvolvimento americana. Qual foi o motivo de tanta popularidade? Um nível de unificação sem precedentes - o chip gráfico Trio64 montou um conversor digital para analógico (DAC), um sintetizador de frequência e um controlador gráfico sob a mesma capa. A novidade do S3 usava um pool de framebuffer e overlay de vídeo de hardware compatível (implementado alocando uma parte da memória de vídeo durante a renderização).A massa de vantagens e a ausência de deficiências óbvias do chip Trio64 e de seu companheiro Trio32 de 32 bits levaram ao surgimento de muitas opções para versões parceiras de placas baseadas nelas. Diamond, ELSA, Sparkle, STB, Orchid, Hercules e Number Nine ofereceram suas soluções. As variações variaram de adaptadores básicos baseados em VirGe por US $ 169, ao ultra-poderoso Diamond Stealth64 com 4 MB de memória de vídeo por US $ 569.

Em março de 1995, a ATI voltou ao grande jogo com um monte de inovações com o lançamento do Mach64, o primeiro acelerador gráfico de 64 bits do mercado e também o primeiro a rodar em sistemas PC e Mac. Junto com o popular Trio 958, Mach64 forneceu recursos de vídeo acelerado por hardware. Mach64 abriu o caminho para a ATI entrar no mercado profissional - as primeiras soluções dos canadenses neste setor foram os aceleradores 3D Pro Turbo e 3DProTurbo + PC2TV. Novos itens foram oferecidos a um preço de US $ 899 por até 4 MB de memória de vídeo.

Outro novato importante no mercado de aceleradores gráficos é a startup de tecnologia 3Dlabs. A direção prioritária para a jovem empresa era o lançamento de aceleradores gráficos de ponta para o mercado profissional - Fujitsu Sapphire2SX com 4 MB de memória de vídeo foi oferecido a um preço de US $ 1600, e ELSA Gloria 8 com 8 MB de memória onboard custou incríveis US $ 2.600 naqueles anos. A 3Dlabs tentou entrar no mercado de gráficos de jogos em massa com o Gaming Glint 300SX, mas o preço alto e apenas 1 MB de memória de vídeo não trouxe popularidade para o adaptador.

Outras empresas também apresentaram seus produtos ao mercado consumidor. A Trident, um fornecedor OEM de soluções gráficas 2D, revelou o chip 9280, que tem todos os benefícios do Trio64 a um preço acessível de US $ 170 a US $ 200. Ao mesmo tempo, o Power Player 9130 da Weitek e o ProMotion 6410 da Alliance Semiconductor foram colocados à venda, o que proporcionou excelente suavidade durante a reprodução de vídeo.

NV1 - estreia NVidia e áreas problemáticas

Em maio de 1995, a NVIDIA juntou-se aos recém-chegados, apresentando seu primeiro acelerador gráfico com o nome simbólico NV1. O produto foi o primeiro no mercado comercial a combinar os recursos de renderização 3D, aceleração de vídeo por hardware e interface gráfica. O sucesso comercial contido não incomodava de forma alguma a jovem empresa - Jen-Hsun Huang e seus colegas sabiam que seria muito difícil “filmar” em um mercado onde novas soluções são apresentadas a cada mês. Mas os lucros da venda da NV1 foram suficientes para manter a empresa à tona e fornecer incentivos para continuar.

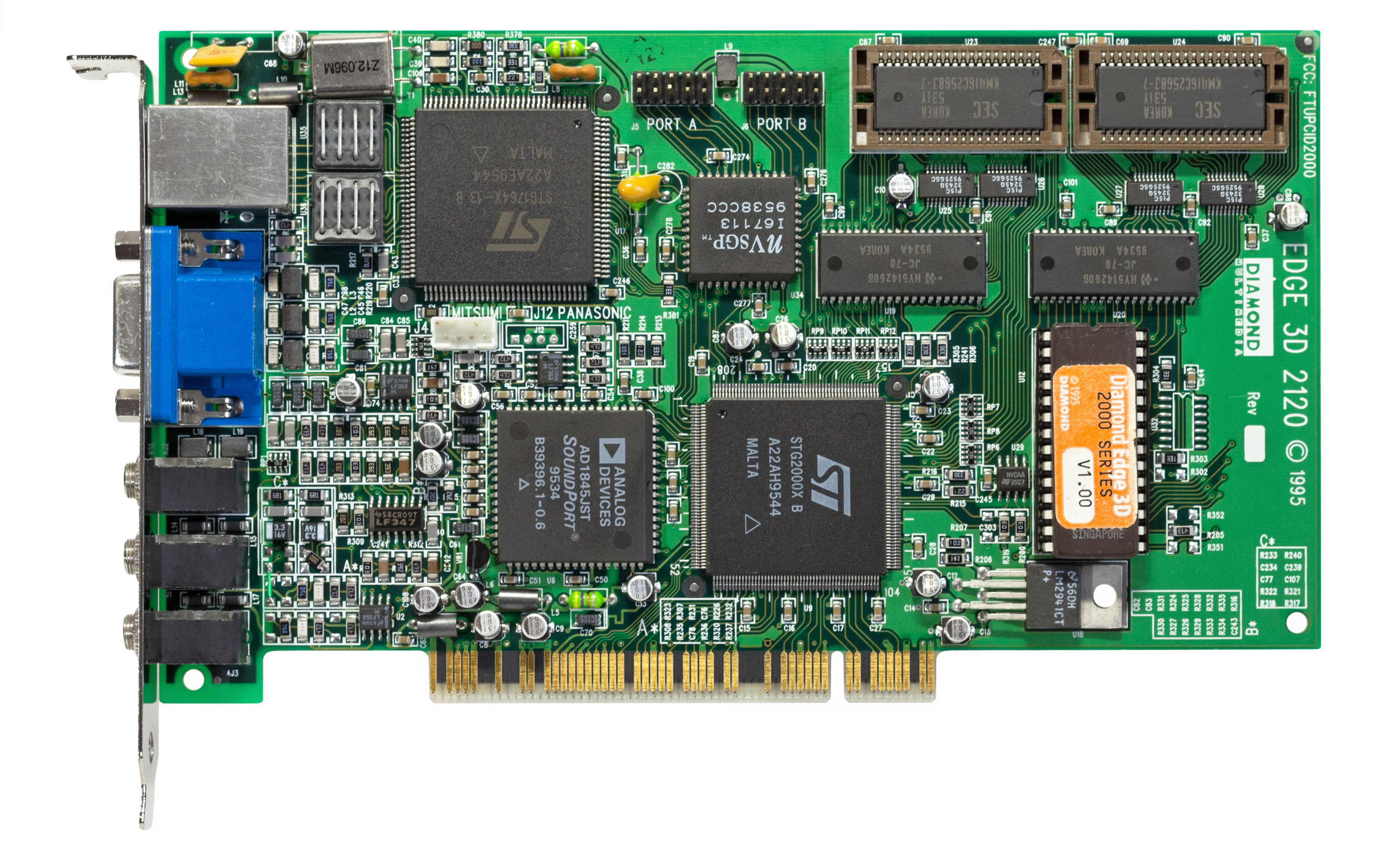

Diamond EDGE 3D 2120 (NV1)

A ST Microelectronics foi responsável pela produção de chips baseados na tecnologia de processo de 500 nm, mas infelizmente para a Nvidia, apenas alguns meses após a introdução de soluções de parceiros baseadas em NV1 (por exemplo, Diamond Edge 3D), a Microsoft apresentou a primeira versão da tão esperada API gráfica DirectX 1.0. "Finalmente!" - exclamaram gamers de todo o mundo, mas os fabricantes de aceleradores gráficos não compartilhavam tanto entusiasmo.

A principal característica do DirectX são os polígonos triangulares. Muitas pessoas acreditam erroneamente que os notórios triângulos sempre existiram, mas na verdade isso é uma ilusão. Os engenheiros da Nvidia incluíram mapeamento de textura quadrática em seu primeiro produto (em vez de triângulos-polígonos havia quadrados), razão pela qual os aplicativos e os primeiros jogos com suporte a DirectX causaram muitos problemas de compatibilidade para proprietários de NV1. Para resolver o problema, a Nvidia incluiu um manipulador para converter marcações de textura quadrada em triangular no driver, mas o desempenho neste formato deixou muito a desejar.

A maioria dos jogos com suporte a mapeamento de textura quadrática foram portados do console Sega Saturn. A Nvidia considerou esses projetos tão importantes que colocou duas portas do novo console no modelo NV1 de 4 MB, conectadas à placa por meio de conectores de fita. Quando foi colocado à venda (setembro de 1995), o primeiro produto da Nvidia custou aos clientes US $ 450.

Quando a API da Microsoft foi lançada, a maioria dos fabricantes de aceleradores gráficos dependia muito de soluções proprietárias de outras empresas - quando os desenvolvedores da empresa de Bill Gates estavam apenas começando a trabalhar em sua própria biblioteca de gráficos, já havia muitas APIs no mercado, como S3d (S3), Matrox Simple Interface, Creative Biblioteca gráfica, C Interface (ATI) e SGL (PowerVR), e mais tarde incluiu NVLIB (Nvidia), RRedline (Rendition) e o famoso Glide. Essa diversidade complicou muito a vida dos desenvolvedores do novo hardware, já que as APIs eram incompatíveis entre si, e diferentes jogos suportavam diferentes bibliotecas. O lançamento do DirectX acabou com todas as soluções de terceiros, porque o uso de outras APIs proprietárias em jogos para Windows simplesmente não fazia sentido.

Mas não podemos dizer que o novo produto da Microsoft não apresentava falhas graves. Depois que o SDK do DirectX foi introduzido, muitos fabricantes de aceleradores gráficos perderam a capacidade de controlar os recursos de hardware das placas de vídeo ao reproduzir vídeo digital. Numerosos problemas de driver no recém-lançado Windows 95 irritaram os usuários acostumados com a operação estável do Windows 3.1. Com o tempo, todos os problemas foram resolvidos, mas a principal batalha do mercado estava pela frente - a ATI, que havia feito uma pausa, se preparava para conquistar o universo dos games tridimensionais com uma nova linha do 3D Rage.

ATI Rage - 3D Rage

A demonstração do novo acelerador gráfico ocorreu na exposição Los Angeles E3 1995. Os engenheiros da ATI combinaram as vantagens do chip Mach 64 (e seus excelentes recursos gráficos 2D) com um novo chip de processamento 3D, aproveitando ao máximo os designs anteriores. O primeiro acelerador 3D ATI 3D Rage (também conhecido como Mach 64 GT) entrou no mercado em novembro de 1995.

ATI 3D Rage

Como no caso da Nvidia, os engenheiros tiveram que enfrentar muitos problemas - as revisões posteriores do DirectX 1.0 causaram vários problemas associados à falta de um buffer profundo. A placa tinha apenas 2 MB de RAM EDO, então os aplicativos e jogos 3D foram lançados com uma resolução de não mais do que 640x480 em cores de 16 bits ou 400x300 em cores de 32 bits, enquanto no modo 2D a resolução da tela era muito maior - até 1280x1024. As tentativas de rodar o jogo em cores de 32 bits em 640x480 geralmente resultavam em artefatos coloridos na tela, e o desempenho do jogo 3D Rage não era excelente. A única vantagem indiscutível da novidade era a possibilidade de reproduzir arquivos de vídeo no formato MPEG em tela cheia.

A ATI trabalhou em bugs e redesenhou o chip com o lançamento do Rage II em setembro de 1996. Tendo corrigido as deficiências de hardware e adicionado suporte para o codec MPEG2, os engenheiros, por algum motivo, não pensaram na necessidade de aumentar o tamanho da memória - os primeiros modelos ainda tinham ridículos 2 MB de memória de vídeo a bordo, o que inevitavelmente afetava o desempenho ao processar geometria e perspectiva. O defeito foi corrigido em revisões posteriores do adaptador - por exemplo, no Rage II + DVD e 3D Xpression +, o buffer de memória cresceu para 8 MB.

Mas a guerra pelo mercado 3D estava apenas começando, com três novas empresas preparando seus produtos para os jogos mais recentes - Rendition, VideoLogic e 3dfx Interactive. Foi este último que conseguiu apresentar um chip gráfico no menor tempo possível, superando significativamente todos os concorrentes e iniciando uma nova era nos gráficos 3D -Gráficos 3Dfx Voodoo .

1996-1999. A era do 3Dfx. A maior inicialização de gráficos de todos os tempos. A última etapa da grande competição pelo mercado

A incrível história de 3Dfx se tornou a personificação de uma startup, simbolizando tanto sucesso incrível e lucros vertiginosos, bem como a incompetência da liderança autoconfiante e, como resultado - colapso e esquecimento. Mas o final triste e a experiência amarga não podem negar o óbvio - 3Dfx sozinho criou uma revolução gráfica, pegando vários concorrentes de surpresa e estabelecendo uma nova barra de desempenho fenomenalmente alto. Nem antes nem depois desse período incrível na história do desenvolvimento das placas de vídeo vimos nada, mesmo remotamente, semelhante ao aumento louco do 3Dfx na segunda metade dos anos noventa.

3Dfx Voodoo Graphics foi um adaptador gráfico destinado exclusivamente a trabalhar com gráficos 3D. Foi assumido que o comprador da novidade utilizará outra placa para trabalhar com cargas bidimensionais, conectando-a à Voodoo através de um segundo conector VGA.

Essa abordagem não confundiu muitos entusiastas, e a solução inovadora imediatamente atraiu muitos fabricantes parceiros que lançaram suas próprias variantes do Voodoo.

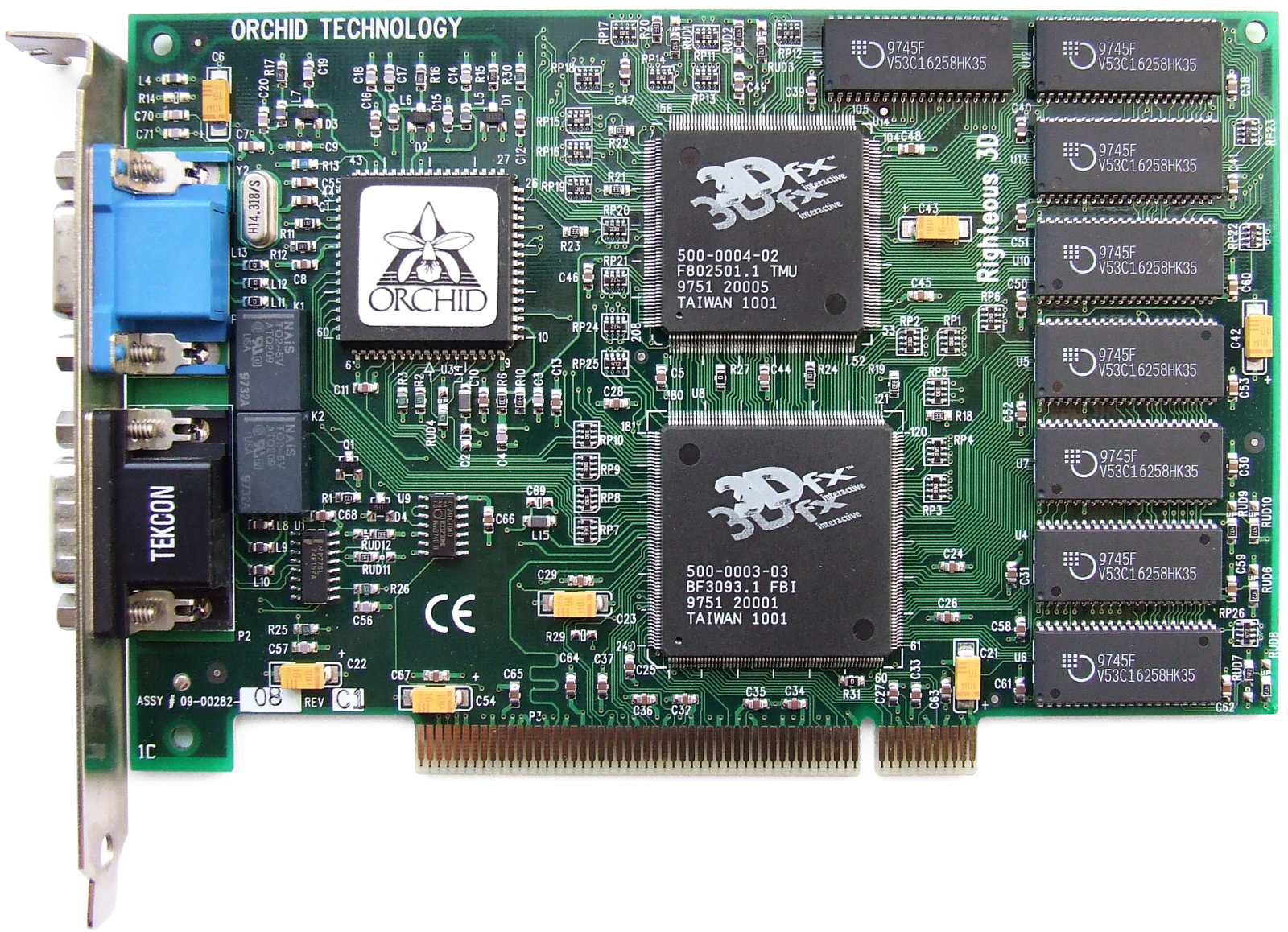

Uma das cartas interessantes baseadas no primeiro chip 3Dfx foi o Orchid Righteous 3D da Orchid Technologies. A marca registrada do adaptador de $ 299 eram relés mecânicos que emitem cliques característicos ao lançar aplicativos ou jogos 3D.

Orchid Righteous 3D

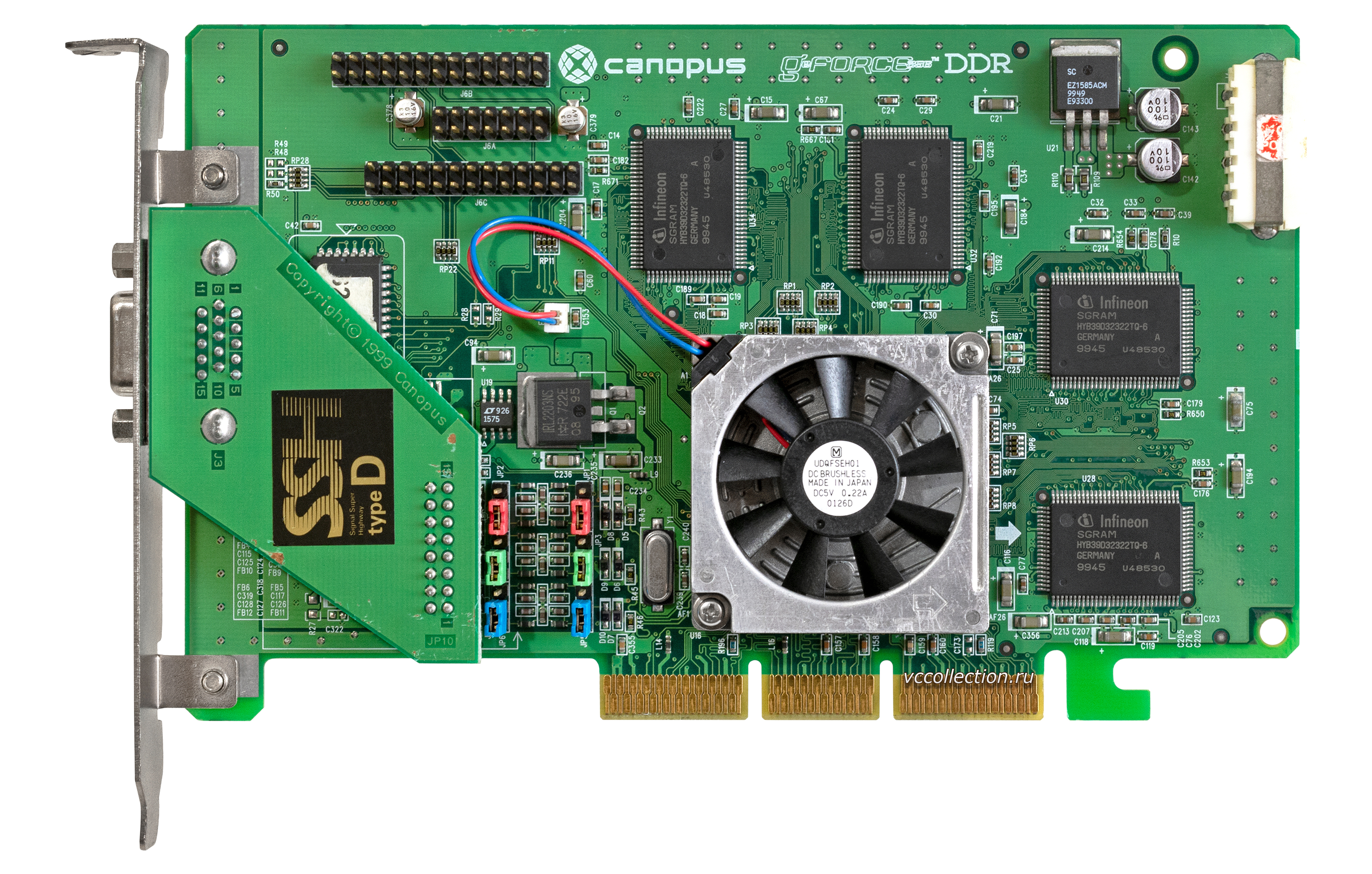

Em revisões posteriores, esses relés foram substituídos por componentes de estado sólido, e o encanto antigo foi perdido. Junto com Orchid, Diamond Multimedia (Monster 3D), Colormaster (Voodoo Mania), Canopus (Pure3D e Quantum3D), Miro (Hiscore), Skywell (Magic3D) e o mais pretensioso em uma série de títulos 2theMAX Fantasy FX Power 3D, também apresentaram suas versões do mais recente acelerador. ... Anteriormente, eles não hesitavam em nomear placas de vídeo!

As razões para essa empolgação em torno da novidade eram óbvias - com todas as deficiências possíveis, Voodoo Graphics tinha um desempenho incrível, e sua aparência imediatamente tornou muitos outros modelos obsoletos - especialmente aqueles que só podiam funcionar com gráficos 2D. Apesar do fato de que em 1996 mais da metade do mercado de aceleradores 3D pertencia ao S3, o 3Dfx estava rapidamente ganhando milhões de fãs e no final de 1997 a empresa detinha 85% do mercado. Foi um sucesso fenomenal.

Concorrentes 3Dfx. Rendition e VideoLogic

Os sucessos retumbantes do novato de ontem não excluíram os competidores do jogo, que mencionamos anteriormente - VideoLogic e Rendition. VideoLogic criou a tecnologia Tiled Deferred Rendering (TBRD) que eliminou a necessidade de pré-Z-buffering de um quadro. No estágio final da renderização, os pixels ocultos foram limpos e o processamento da geometria começou apenas depois que as texturas, sombras e iluminação foram aplicadas. A tecnologia TBRD funcionava com base no princípio de dividir um quadro em células retangulares, nas quais os polígonos eram renderizados independentemente uns dos outros. Nesse caso, os polígonos localizados fora da área visível do quadro foram eliminados, e a renderização do restante começou somente após o cálculo do número total de pixels. Essa abordagem permitiu economizar muitos recursos de computação na fase de renderização de quadros,melhorando significativamente o desempenho geral.

A empresa trouxe ao mercado três gerações de chips gráficos da NEC e ST Micro. A primeira geração era um produto exclusivo em computadores Compaq Presario chamado Midas 3 (Midas 1 e 2 eram protótipos usados em máquinas de arcade). O PSX1 e o PSX2 lançados posteriormente estavam focados no mercado OEM.

Os chips de segunda geração formaram a base do Sega Dreamcast, a plataforma japonesa que desempenhou um papel no triste destino da 3Dfx. Ao mesmo tempo, a VideoLogic não teve tempo de entrar no mercado consumidor de placas gráficas - na época da estreia, seu modelo Neon 250 havia se tornado obsoleto, perdendo para todas as soluções de orçamento, e isso não é surpreendente, porque a novidade chegou às prateleiras apenas em 1999.

Rendition também se destacou em inovações gráficas e criou o primeiro chip gráfico Vérité 1000 com a capacidade de trabalhar não só com 2D, mas também com gráficos 3D simultaneamente graças ao núcleo do processador na arquitetura RISC, bem como ao uso de pixel pipelines. O processador era responsável pelo processamento dos polígonos e pelo mecanismo dos pipelines de renderização.

A Microsoft estava interessada nesta abordagem para construir e processar imagens - a empresa usou o Vérité 1000 durante o desenvolvimento do DirectX, mas o acelerador tinha suas próprias falhas arquitetônicas. Por exemplo, funcionava apenas em placas-mãe com suporte para a tecnologia de acesso direto à memória (DMA), que transferia dados via barramento PCI. Devido ao seu baixo custo e uma série de vantagens de software, incluindo anti-aliasing e aceleração de hardware no Quake da id Software, a placa era popular até a Voodoo Graphics. O novo produto da 3Dfx revelou-se mais de 2 vezes mais eficiente e a tecnologia DMA rapidamente perdeu popularidade entre os desenvolvedores de jogos, enviando o outrora promissor V1000 para a lata de lixo da história.

ATI - Race for Voodoo com Rage II e Rage Pro

Enquanto isso, a ATI não parou de trabalhar em novas revisões do Rage. Após o Rage II em março de 1997, o Rage Pro foi apresentado - a primeira placa de vídeo AGP do ATI 3D Engineering Group formada no dia anterior.

O Rage Pro com 4 MB de memória de vídeo a bordo praticamente igualou o lendário Voodoo em desempenho, e a versão no barramento AGP com 8 MB de memória de vídeo chegou a superar o famoso concorrente em vários jogos. Na versão Pro da placa, os engenheiros da ATI melhoraram a correção de perspectiva e o processamento de textura, bem como adicionaram suporte para anti-aliasing de hardware e filtragem trilinear graças ao cache aumentado de 4KB. Para reduzir a dependência do desempenho do adaptador no processador central do computador, um chip separado foi soldado na placa para processar operações de ponto flutuante. Os fãs de multimídia moderna apreciaram o suporte para aceleração de hardware ao reproduzir vídeo de mídia de DVD.

A entrada do Rage Pro permitiu que a ATI melhorasse suas finanças e aumentasse seu lucro líquido para US $ 47,7 milhões em um faturamento total de mais de US $ 600 milhões. A maior parte do sucesso financeiro do produto veio de contratos OEM, a implementação do chip gráfico nas placas-mãe e o lançamento de uma variante móvel. A placa, que costumava ser vendida nas variantes Xpert @ Work e Xpert @ Play, tinha várias configurações de 2 a 16 MB de memória de vídeo para diferentes necessidades e segmentos de mercado.

Uma vantagem estratégica importante para a equipe da ATI foi a aquisição de US $ 3 milhões do Tseng Labs, que trabalhou em tecnologias para integrar chips RAMDAC em placas de vídeo. A empresa estava desenvolvendo seu próprio adaptador gráfico, mas enfrentou problemas técnicos, o que levou a uma contra-oferta dos líderes do mercado canadense. Junto com a propriedade intelectual, 40 engenheiros de primeira linha foram transferidos para a equipe da ATI e imediatamente começaram a trabalhar.

Novos concorrentes. Permedia e RIVA 128

Os profissionais da 3DLabs nunca desistiram da esperança de capturar os interesses dos jogadores. Para isso, foi lançada uma série de produtos Permedia, fabricados com a tecnologia de processo Texas Instruments 350 nm. O Permedia original teve um desempenho relativamente ruim, que foi corrigido no Permedia NT. A nova placa tinha um chip Delta separado para o processamento de polígonos e um algoritmo de anti-aliasing, mas ao mesmo tempo era caro - chegava a US $ 600. Quando a linha Permedia 2 atualizada estava pronta no final de 1997, ela não podia mais competir com produtos de jogos - a 3DLabs mudou o marketing e apresentou novos itens como cartões profissionais para trabalhar com aplicativos 2D e suporte 3D limitado.

Apenas um mês após as estreias do 3DLabs e da ATI, a Nvidia está de volta ao mercado com sua RIVA 128, uma carteira para jogadores altamente competitiva. Preço acessível e excelente desempenho em Direct3D garantiram ao novo produto reconhecimento universal e sucesso comercial, permitindo que a empresa fechasse um contrato com a TSMC para a produção de chips para o RIVA 128ZX atualizado. No final de 1997, duas placas de vídeo de sucesso trouxeram para Jensen Huang 24% do mercado - quase tudo que o todo poderoso 3Dfx não teve tempo de esmagar.

Ironicamente, os caminhos entre a Nvidia e o líder de mercado começaram a se cruzar já quando a Sega, se preparando para o desenvolvimento do novo console Dreamcast, firmou vários contratos preliminares com fabricantes de soluções gráficas. Entre eles estavam a Nvidia (com o design do chip NV2) e 3Dfx (com o protótipo Blackbelt). A gerência da 3Dfx estava completamente confiante em receber o contrato, mas, para sua surpresa, foi recusado - os japoneses optaram por não arriscar e recorreram à NEC para o desenvolvimento, que já havia provado ser uma colaboração com a Nintendo. Representantes da 3Dfx entraram com um processo contra a Sega, acusando a empresa de ter a intenção de desviar desenvolvimentos proprietários no decorrer do trabalho no protótipo - um longo litígio terminou em 1998 com o pagamento de uma indenização no valor de $ 10,5 milhões em favor da empresa americana.

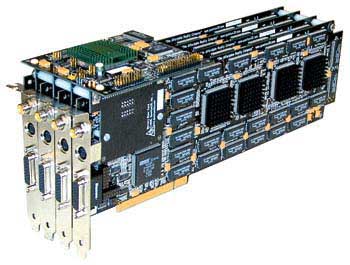

Quantum3D e o primeiro uso de SLI

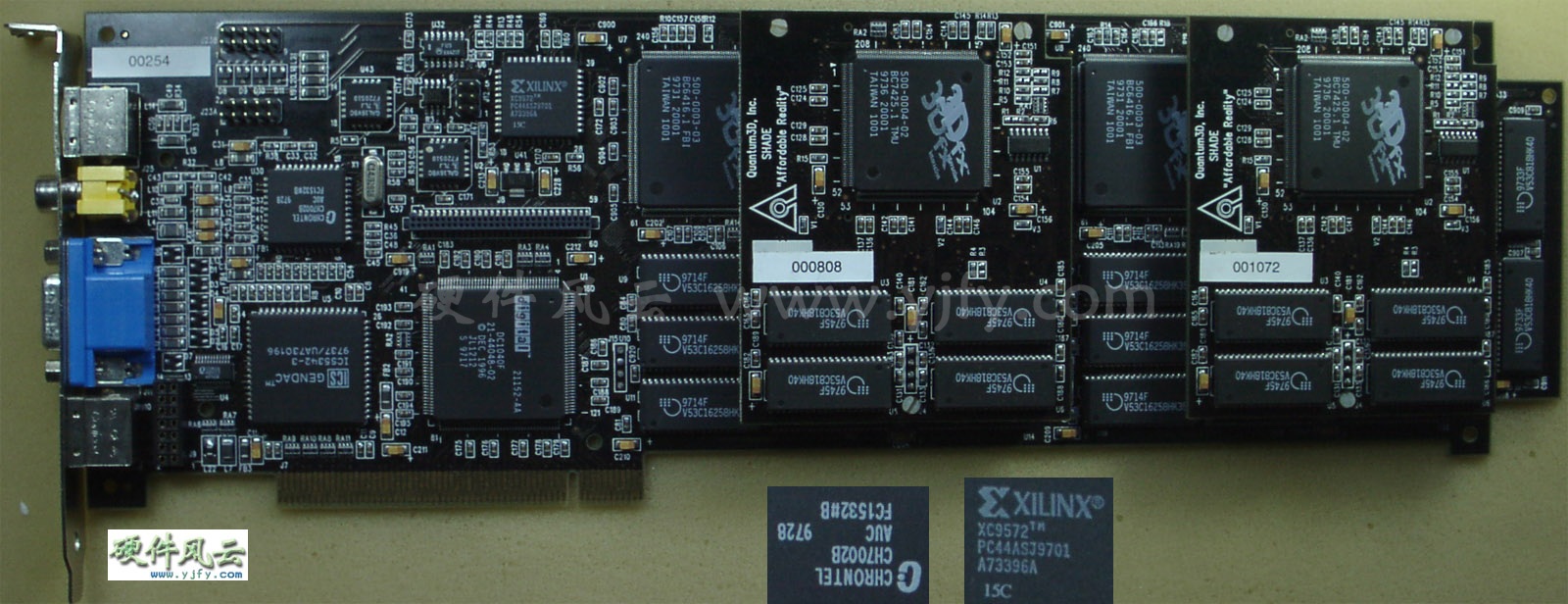

Nesse ínterim, eles continuaram, 3Dfx conseguiu adquirir uma empresa subsidiária. Ela era a Quantum3D, que recebeu diversos contratos lucrativos para o desenvolvimento de soluções gráficas profissionais do mais alto nível da SGI e Gemini Technology. Os futuros produtos foram baseados no desenvolvimento inovador da tecnologia 3Dfx - SLI (Scan-Line Interleave) .

A tecnologia supôs a possibilidade de usar dois chips gráficos (cada um com seu próprio controlador de memória e buffer) em uma placa ou conectar duas placas separadas usando um cabo de fita especial. Cartões conectados de forma semelhante (no formato de um cartão de chip duplo ou dois separados) dividiam o processamento de imagem pela metade. A tecnologia SLI fornecia a capacidade de aumentar a resolução da tela de 800x600 para 1024x768 pixels, mas esse luxo não era barato: o Obsidian Pro 100DB-4440 (duas placas emparelhadas com chips Ametista) foi oferecido a um preço de $ 2500, enquanto a placa de chip duplo 100SB-4440 / 4440V teria custado ao comprador em $ 1895.

Obsidian Pro 100DB-4440

Soluções especializadas, entretanto, não desviaram os líderes de mercado do desenvolvimento de novos cartões Voodoo.

3Dfx Voodoo Rush. Pressa, orçamento e frustração

No verão de 1997, 3Dfx se tornou público e tentou consolidar o sucesso esmagador do Voodoo lançando o Voodoo Rush, uma placa que funciona com gráficos 2D e 3D simultaneamente, e não requer mais um segundo adaptador. Inicialmente, deveria ser baseado no novo chip Rampage, mas devido a problemas técnicos, seu lançamento foi adiado e o Rush foi baseado em uma versão simplificada do Voodoo original. Para acomodar os dois tipos de cargas de trabalho gráficas, a placa abrigava dois chips - o SST-1 era responsável pelo processamento de jogos 3D usando a API Glide, enquanto o chip mais medíocre da Alliance ou Macronix era responsável por outros aplicativos e jogos 2D e 3D. Devido à dessincronização, os chips funcionavam em frequências diferentes (50 e 72 MHz), causando artefatos aleatórios na tela e confusão para os proprietários.

Voodoo rush

Além disso, o Voodoo Rush tinha um buffer de memória de vídeo comum, que os dois chips usavam simultaneamente. A resolução máxima da tela sofreu com isso - era apenas metade de 1024x768 (512x384 pixels), e as baixas frequências de RAMDAC não permitiam fornecer os 60 Hz desejados na atualização da tela.

Rendition V2100 e V2200. Saindo do mercado

Em meio a grandes problemas com o 3Dfx, a Rendition fez outra tentativa de surpreender agradavelmente o mercado de massa com a Rendition V2100 e V2200. As novidades chegaram ao mercado logo após a estreia de Voodoo Rush, mas, para a decepção dos entusiastas, não conseguiram competir nem mesmo com o vodu despojado. As placas gráficas não reclamadas forçaram a Rendition a ser a primeira de muitas a deixar o mercado de placas gráficas.

Como resultado, muitos dos projetos da empresa permaneceram no estágio de protótipo - um deles foi uma versão modificada do V2100 / V2200 com um processador geométrico Fujitsu FXG-1 (em formato dual-chip). No entanto, havia também uma variante de chip único com FXG-1, que ficou para a história como o produto com o nome mais requintado da história - Hercules Thrilled Conspiracy. Junto com outros desenvolvimentos (por exemplo, os chips V3300 e 4400E), a empresa foi vendida para a Micron por $ 93 milhões em setembro de 1998.

Economia agressiva. Batalha pelo segmento de orçamento

O crescimento constante da produtividade e o surgimento de novas vantagens técnicas tornaram extremamente difícil para os fabricantes de segundo nível competir com as soluções da ATI, Nvidia e 3Dfx, que ocupavam não apenas o nicho de entusiastas e profissionais, mas também o segmento "popular" do mercado de adaptadores abaixo de US $ 200.

A Matrox lançou sua placa de vídeo Mistique a um preço saboroso de US $ 120 a US $ 150, mas devido à falta de suporte para OpenGL, o novo produto imediatamente caiu na categoria de azarões. A S3 começou a vender a nova linha ViRGE, com a presença da mais ampla gama possível - a versão mobile do adaptador com gerenciamento dinâmico de energia (ViGRE / MX), e uma versão especial do ViRGE principal com suporte para saída de TV, conector S-Video e reprodução de DVD (ViRGE / GX2). Dois adaptadores principais projetados para lutar pelo mercado de orçamento (modelos ViRGE, VIRGE DX e ViRGE GX) custam de $ 120 para o mais jovem a $ 200 para o mais velho na época do lançamento.

É difícil imaginar, mas a categoria ultra-econômica também foi um local de competição acirrada. Laguna3D da CirrusLogic, modelos 9750/9850 da Trident e SiS 6326 competiam pelas carteiras de usuários dispostos a pagar não mais que $ 99 por um acelerador gráfico.Todas essas placas eram comprometidas com um mínimo de recursos.

Após o lançamento do Laguna3D, a CirrusLogic deixou o mercado - gráficos 3D de baixa qualidade, desempenho medíocre (e inconsistente), bem como concorrentes muito mais interessantes (o mesmo ViRGE, que custou um pouco mais) não deram aos veteranos da indústria uma chance de sobreviver. As únicas fontes de receita para a CirrusLogic eram a venda de adaptadores gráficos de 16 bits antediluvianos por US $ 50, interessantes apenas para os clientes mais econômicos.

A Trident também viu potencial no segmento de mercado “abaixo da média” - em maio de 1997, o 3D Image 9750 foi lançado e, um pouco depois, o 9850 foi lançado com suporte para um barramento AGP de canal duplo. Depois de consertar muitos dos problemas de barramento PCI do 9750, o 9850 sofreu com o processamento de textura medíocre e recebeu poucos elogios.

Entre os cartões vendidos por quase nada, o mais bem-sucedido foi o SiS 6326, lançado em junho de 1997 por menos de US $ 50. Com boa qualidade de imagem e desempenho relativamente alto, o 6326 vendeu mais de 8 milhões de unidades em 1998. Mas no final dos anos 90, o mundo entusiasta foi abalado por uma startup cheia de promessas sérias - era o BitBoys.

BitBoys - caras ousados em um mundo 3D fabuloso

A BitBoys se anunciou em junho de 1997 com o anúncio do intrigante projeto Pyramid3D. O revolucionário chip gráfico foi desenvolvido em conjunto com a própria startup Silicon VLSI Solutions Oy e TriTech. Infelizmente para os entusiastas, exceto pelos palavrões nas apresentações do Pyramid3D, ele nunca apareceu em lugar nenhum, e a TriTech foi condenada por se apropriar da patente de outra pessoa para um chip de áudio, razão pela qual mais tarde ele faliu e fechou.

Mas o BitBoys não parou de funcionar e anunciou um segundo projeto chamado Glaze3D. Realismo incrível, desempenho de primeira classe e uma série das tecnologias mais recentes foram mostrados ao público no SIGGRAPH99. O protótipo funcional do adaptador gráfico usou o RAMBUS e 9 MB de DRAM de vídeo da Infineon.

Infelizmente, assim como da primeira vez, problemas e transferências de hardware levaram ao fato de que a revolução esperada não aconteceu novamente.

Captura de tela promocional, projetada para enfatizar o realismo que os cartões Glaze3D deveriam alcançar.

Muito mais tarde, o projeto foi renomeado para Axe novamente, e jogos com suporte a DirectX 8.1 foram escolhidos como o campo de competição - o protótipo ainda conseguiu o nome oficial de Avalanche3D e prometeu "explodir" o mercado em 2001, mas não Aconteceu. No último estágio de desenvolvimento, Axe mudou para o Hammer, ao qual foi prometido suporte para DirectX 9.0. A história da construção de longo prazo mais pretensiosa da história da gráfica terminou com a falência da Infineon, após a qual a BitBoys abandonou o "projeto dos sonhos" e passou para o segmento gráfico móvel. Agora vamos voltar ao aconchegante 1998.

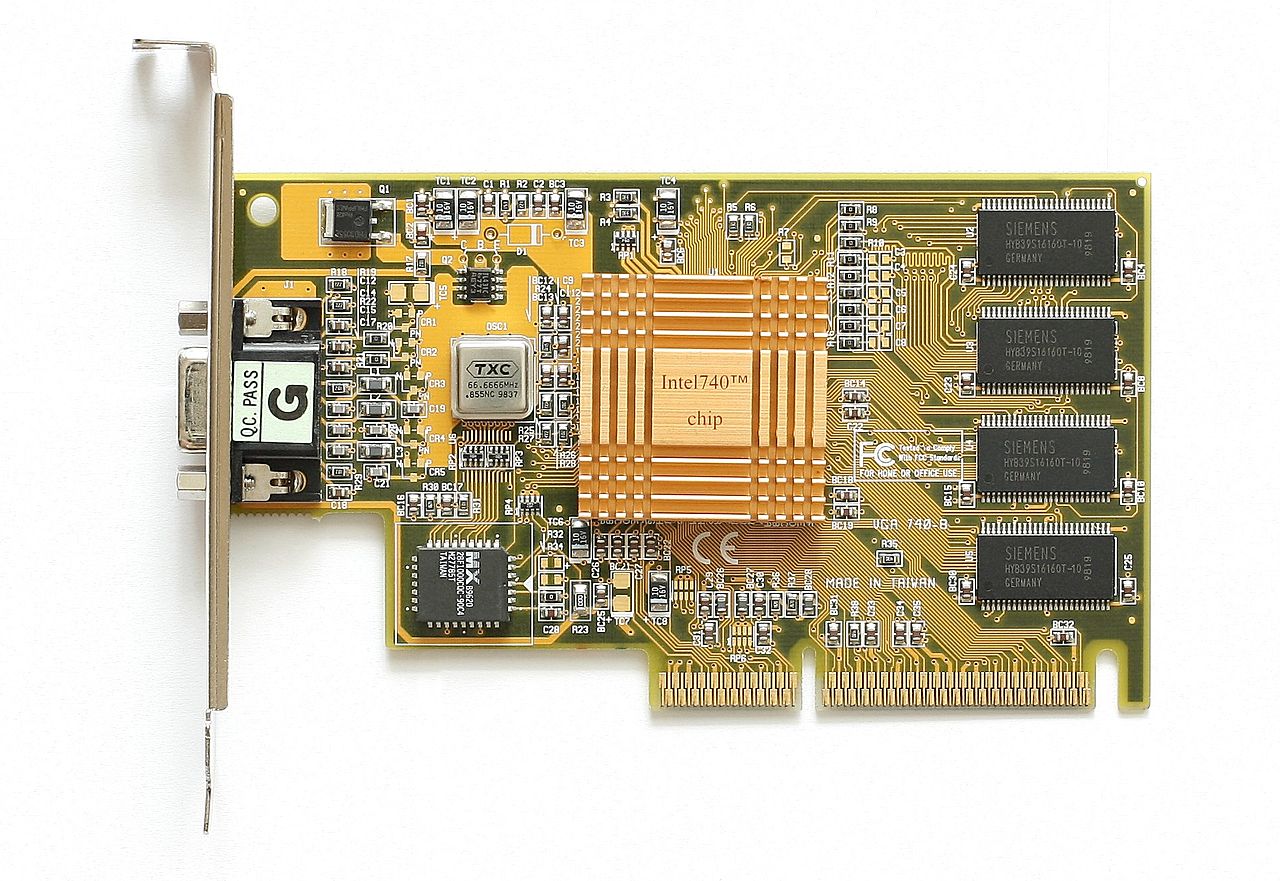

Intel i740 - Grande fracasso de grandes profissionais

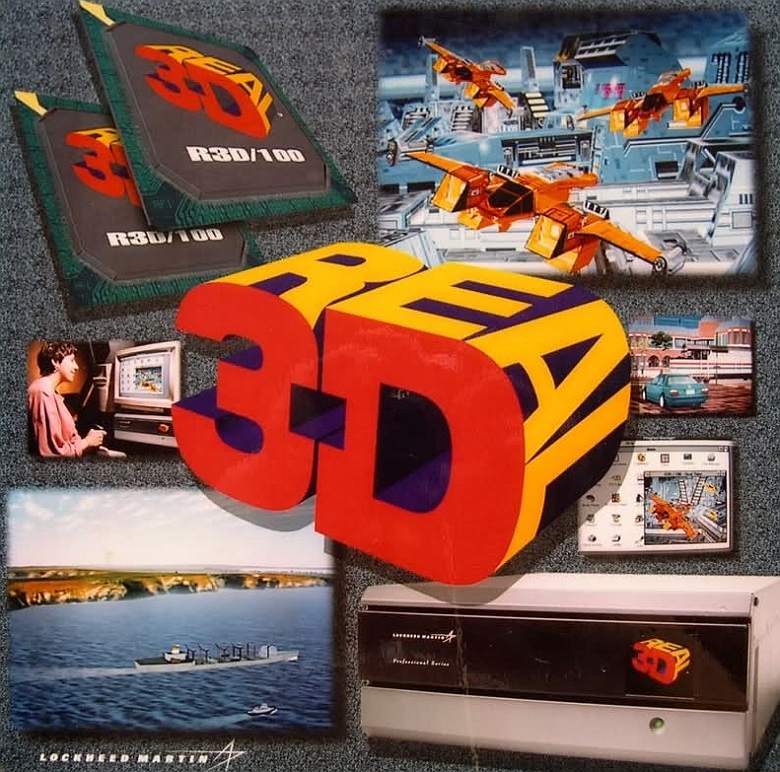

A Intel lançou sua primeira (e até agora a última) placa de vídeo para jogos 3D chamada Intel i740 em janeiro de 1998. O projeto tinha uma história interessante, pois estava enraizado em um programa de simulação de vôo espacial que a NASA e a General Electric criaram para a famosa série Apollo de missões lunares. Mais tarde, os empreendimentos foram vendidos para Martin Marietta, uma empresa que mais tarde se tornou parte da gigante da defesa Lockheed (e é assim que a Lockheed-Martin apareceu). Lockheed-Martin com base no projeto criou uma linha de dispositivos profissionais Read3D, composta por dois modelos de adaptadores gráficos - Real3D / 100 e Real3D / Pro-1000. Ironicamente, apesar da origem militar dos dispositivos, uma das aplicações de tecnologias excepcionais tornou-se ... uma máquina de arcade Sega usando duas placas Pro-1000.

Um pouco mais tarde, a Lockheed-Martin anunciou o início do Projeto Aurora, uma colaboração com a Intel e Chips and Technologies. Um mês antes do lançamento do i740, a Intel adquiriu 20% do projeto Real3D e, em julho de 1997, havia adquirido completamente os chips e tecnologias.

Uma característica chave do projeto Real3D foi o uso de dois chips separados para processar texturas e gráficos - a Intel os combinou para criar o i740. O adaptador usou uma abordagem original para buffer de dados - o conteúdo do buffer de quadros e as texturas foram carregados diretamente na RAM do computador por meio do barramento AGP. Nas versões parceiras do i740, o acesso à RAM ocorria apenas se o buffer do adaptador estivesse completamente preenchido ou altamente segmentado. A mesma abordagem é freqüentemente usada hoje - quando a memória na placa de vídeo se esgota, o sistema aumenta o buffer usando RAM livre.

Mas em uma época em que os buffers eram contados em megabytes e as texturas ainda não estavam aumentadas para tamanhos obscenos, essa abordagem pode parecer pelo menos estranha.

Para reduzir possíveis latências ao trabalhar com o barramento, a Intel usou um de seus recursos - acesso direto ao buffer de memória (Direct Memory Execute ou DiME). Esse método também era chamado de texturização AGP, e permitia usar a RAM do computador para mapear texturas, processando-as seletivamente. O desempenho médio juntamente com a qualidade de imagem medíocre permitiram que o i740 atingisse o nível dos cartões do ano passado em seu segmento de preço.

Para o modelo com 4 MB de memória de vídeo, eles pediram US $ 119, e a versão com 8 MB custou US $ 149. Além disso, além da versão básica da Intel, apenas duas opções de parceiros viram a luz - Real3D StarFighter e Diamond Stealth II G450.

Contando com o sucesso, a Intel começou a desenvolver o próximo chip i752, mas nem os OEMs nem os entusiastas mostraram interesse em um adaptador de orçamento que está seriamente aquém das soluções atuais. E isso não é surpreendente, porque ao mesmo tempo estava à venda o ViRGE do S3, cuja compra agradaria muito mais ao usuário. A produção de adaptadores foi descontinuada e os chips i752 que entraram no mercado foram reaproveitados para uso como soluções gráficas integradas.

Em outubro de 1999, a Lockheed-Martin eliminou o Real3D e a rica força de trabalho foi para a Intel e a ATI.

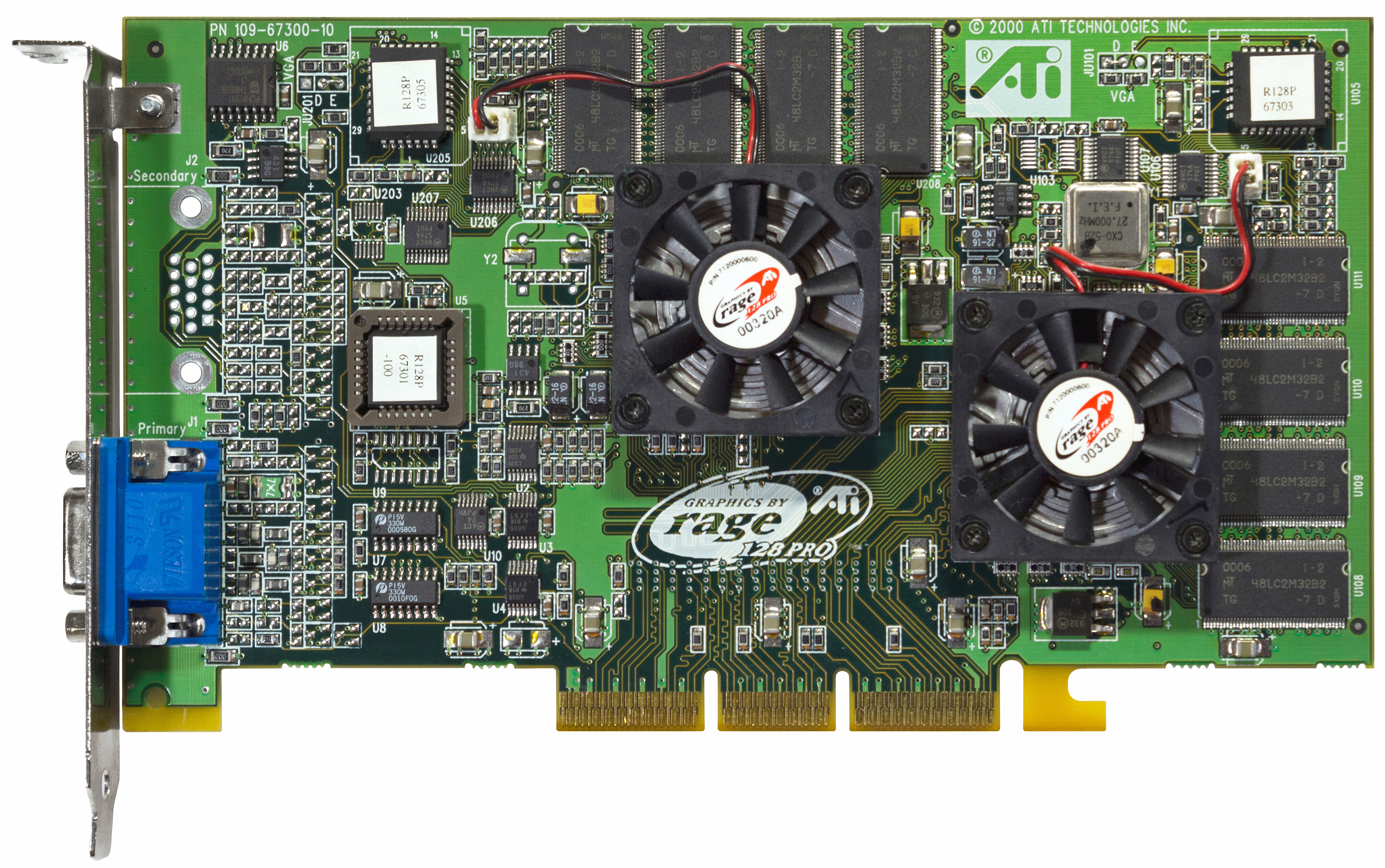

ATI - De volta ao jogo com Rage Pro e Rage 128

A ATI se restabeleceu com o Rage Pro Turbo em fevereiro de 1998, mas esta placa acabou sendo apenas uma reformulação da Rage Turbo com ajustes de driver para resultados excelentes em textos sintéticos. Os revisores de algumas publicações ficaram agradavelmente surpresos, mas o preço de $ 449 era muito difícil de justificar. No entanto, foi com o Rage Pro Turbo que o fenômeno Finewine apareceu pela primeira vez - os drivers gradualmente melhoraram o desempenho do adaptador a cada nova revisão.

A ATI fez uma tentativa muito mais séria de influenciar o equilíbrio de poder com o lançamento do Rage 128 GL e do Rage 128 VR em agosto do mesmo ano. Devido a problemas de abastecimento, a ATI não conseguiu garantir a disponibilidade dos modelos nas lojas quase até as férias de inverno, o que afetou muito a promoção de novos produtos. Ao contrário dos contratos OEM, que sempre trazem grandes lucros aos canadenses, os entusiastas comuns não puderam apreciar o novo produto devido à falta de adaptadores no mercado. Mas havia outro motivo pelo qual as vendas do Rage 128 foram menores do que o esperado.

A ATI preparou o Rage 128 para um futuro gráfico brilhante equipando o novo produto com 32 MB de memória de vídeo (variantes com 16 MB foram produzidas sob a marca All-In-Wonder 128), que funcionou em um subsistema rápido e eficiente - em cores de 32 bits, o concorrente direto da NVidia Riva TNT não tinha sem chances. Infelizmente, no momento do lançamento do novo produto, a maioria dos jogos e aplicativos ainda funcionavam no modo 16 bits, onde o Rage 128 não se destacava de forma alguma contra o fundo da NVidia e do S3 (e em termos de qualidade de imagem era ainda inferior aos modelos da Matrox). O público em geral não gostou da abordagem da ATI, mas foi então que os canadenses estiveram à frente de seu tempo pela primeira vez - apenas sua abordagem foi apreciada muito mais tarde.

1998 foi um ano recorde para a ATI - com um faturamento de US $ 1,15 bilhão, o lucro líquido da empresa totalizou US $ 168,4 milhões. A canadense encerrou o ano com 27% do mercado de aceleradores gráficos.

Em outubro de 1998, a ATI adquiriu a Chromatic Research por $ 67 milhões. A empresa, famosa por seus processadores de mídia MPACT, era um provedor de soluções de PC TV da Compaq e Gateway, oferecendo excelente desempenho MPEG2, alta qualidade de áudio e excelente desempenho 2D. Ironicamente, foi a única desvantagem da MPACT na forma de baixo desempenho 3D que levou a Chromatic Research à beira da falência apenas 4 anos após sua fundação. O tempo das soluções universais estava cada vez mais perto.

3Dfx Voodoo 2 e Voodoo Banshee - Fracasso bem-sucedido do líder de mercado

Enquanto a Intel tentava entrar no mercado gráfico, seu líder, 3Dfx, apresentou o Voodoo 2, que se tornou um avanço tecnológico em várias áreas ao mesmo tempo. O novo adaptador gráfico da 3Dfx tinha um design único - além do chip central, a placa tinha dois processadores de textura emparelhados, graças aos quais a placa não era apenas de três chips, mas também fornecia a possibilidade de processamento de multi-textura em OpenGL (quando duas texturas eram aplicadas a um pixel ao mesmo tempo, acelerando a renderização geral da cena) que nunca foi usado antes. Assim como o Voodoo original, a placa funcionava exclusivamente em modo 3D, mas ao contrário de seus concorrentes que combinavam processamento 2D e 3D em um único chip, 3Dfx não se comprometeu, perseguindo o objetivo principal - defender a posição de líder de mercado.

As versões profissionais do novo adaptador não demoraram a chegar - a subsidiária 3Dfx Quantum3D lançou três aceleradores notáveis com base na novidade - um Obsidian2 X-24 de dois chips, que poderia ser usado em conjunto com uma placa 2D, SB200 / 200Sbi com 24 MB de memória EDO a bordo, bem como Mercury Heavy Metal - um sanduíche exótico em que 200Sbi emparelhados foram interconectados por uma placa de contato Aalchemy, que no futuro se tornou o protótipo da famosa ponte SLI NVidia.

Mercury Heavy Metal

Este último foi projetado para simulações gráficas complexas e estava disponível por um preço espacial de US $ 9999 . O monstro MHM exigia uma placa-mãe de servidor Intel BX ou GX series com quatro slots PCI para funcionar corretamente.

Percebendo a importância do controle sobre o orçamento do mercado, em junho de 1998 a 3Dfx apresentou o Voodoo Banshee - o primeiro acelerador gráfico com suporte para os modos de operação 2D e 3D. Contrariando as expectativas e esperanças, o lendário chip Rampage nunca ficou pronto, e a placa tinha apenas uma unidade de processamento de textura a bordo, o que praticamente destruiu o desempenho da novidade na renderização multipoligonal - o Voodoo 2 era muito mais rápido. Mas mesmo que a produção econômica com uma marca reconhecível garantisse boas vendas para Banshee, a decepção dos fãs não desapareceu em lugar nenhum - muito mais era esperado dos criadores “daquele mesmo Voodoo”, que da noite para o dia virou o mercado gráfico.

Além disso, apesar da liderança do Voodoo 2, a diferença em relação aos concorrentes estava diminuindo rapidamente. Tendo imposto forte concorrência à ATI e à NVidia, a 3Dfx enfrentou soluções cada vez mais avançadas, e somente graças a uma gestão eficaz (3Dfx produziu e vendeu os próprios cartões, sem a participação de parceiros) a empresa obteve um lucro significativo com as vendas. Mas a gestão da 3Dfx viu muitas oportunidades na aquisição de suas próprias fábricas para a produção de wafers de silício, então a empresa comprou a STB Technologies por US $ 131 milhões com a expectativa de reduzir drasticamente os custos de produção e impor concorrência aos fornecedores Nvidia (TSMC) e ATI (UMC). Este negócio se tornou fatal na história da 3Dfx - as fábricas mexicanas da STB estavam irremediavelmente atrás dos concorrentes asiáticos em termos de qualidade de produto e não podiam competir na corrida pelo processo tecnológico.

Depois que a aquisição da STB Technologies se tornou conhecida, a maioria dos parceiros 3Dfx não apoiou a decisão duvidosa e mudou para os produtos NVidia.

Nvidia TNT - Pedido de Liderança Técnica

E a razão para isso foi o Riva TNT apresentado pela Nvidia em 23 de março de 1998. Ao adicionar um pipeline de pixel paralelo à arquitetura Riva, os engenheiros dobraram a renderização e a velocidade de renderização, o que, junto com 16 MB de memória SDR, aumentou significativamente o desempenho. O Voodoo 2 usava memória EDO muito mais lenta - e isso deu ao novo produto da Nvidia uma vantagem significativa. Infelizmente, a complexidade técnica do chip deu frutos - devido a erros de hardware na produção do chip TSMC de 350 nm não funcionou nos 125 MHz concebidos pelos engenheiros - a frequência muitas vezes caiu para 90 MHz, razão pela qual o Voodoo 2 foi capaz de manter o título de líder formal em desempenho.

Mas mesmo com todas as suas falhas, o TNT era um novo produto impressionante. Graças ao uso do barramento AGP de canal duplo, a placa oferece suporte para resoluções de jogos de até 1600x1200 com cores de 32 bits (e um Z-buffer de 24 bits para garantir a profundidade da imagem). No contexto do Voodoo 2 de 16 bits, o novo produto da nVidia parecia uma verdadeira revolução nos gráficos. Embora TNT não fosse o líder em benchmarks, permaneceu perigosamente perto do Voodoo 2 e Voodoo Banshee, oferecendo mais novas tecnologias, melhor escalonamento na frequência do processador e processamento de textura e 2D de maior qualidade graças ao barramento AGP progressivo. A única desvantagem, como no caso do Rage 128, eram os atrasos na entrega - um grande número de adaptadores apareceu à venda apenas no outono, em setembro de 1998.

Outra mancha na reputação da Nvidia em 1998 foi uma ação judicial da SGI, segundo a qual a NVidia infringiu os direitos de patente de sua tecnologia de mapeamento de textura interna. Como resultado do contencioso, que durou um ano inteiro, foi concluído um novo acordo, segundo o qual a NVidia teve acesso às tecnologias SGI, e a SGI teve a oportunidade de utilizar os desenvolvimentos da Nvidia. Ao mesmo tempo, a divisão gráfica da própria SGI foi dissolvida, o que só beneficiou o futuro líder gráfico.

Número Nove - Passo Lateral

Enquanto isso, em 16 de junho de 1998, o fabricante de gráficos OEM Number Nine decidiu tentar a sorte no mercado de placas de vídeo lançando uma placa Revolution IV sob sua própria marca.

Ficando muito atrás das soluções principais da ATI e Nvidia, a Number Nine se concentrou no setor empresarial, oferecendo a grandes empresas o que as placas clássicas para jogos e gráficos 3D eram fracos - suporte para altas resoluções em cores de 32 bits.

Para ganhar o interesse de grandes empresas, a Number Nine integrou um conector OpenLDI de 36 pinos proprietário em seu Revolution IV-FP e vendeu a placa com um monitor SGI 1600SW de 17,3 polegadas (compatível com resolução de 1600x1024). O conjunto custou $ 2.795.

A oferta não teve muito sucesso, e a Number Nine voltou a emitir cartões de parceiros S3 e Nvidia até ser comprada pela S3 em dezembro de 1999 e depois vendida para os ex-engenheiros da empresa que formaram a Silicon Spectrum em 2002.

S3 Savage3D - Uma alternativa econômica para Voodoo e TNT por US $ 100

O campeão de orçamento na pessoa de S3 Savage estreou na E3 1998 e, ao contrário dos dominadores sofredores do segmento acima (Voodoo Banshee e Nvidia TNT), chegou às prateleiras um mês após o anúncio. Infelizmente, a correria não passou despercebida - os drivers estavam "crus" e o suporte a OpenGL foi implementado apenas no Quake, porque não pude ignorar um dos jogos mais populares do ano, o S3.

As frequências do S3 Savage também não eram suaves. Devido a falhas de fabricação e alto consumo de energia, os modelos de adaptador de referência esquentaram muito e não forneceram o limite de frequência pretendido de 125 MHz - a frequência geralmente flutuava entre 90 e 110 MHz. Ao mesmo tempo, revisores de publicações importantes colocaram as mãos em amostras de engenharia que funcionaram corretamente a 125 MHz, que forneceram belos números em todos os tipos de benchmarks, juntamente com elogios da imprensa especializada. Mais tarde, problemas iniciais em modelos de parceiros foram resolvidos - Savage3D Supercharged funcionava de forma estável a 120 MHz, e Terminator BEAST (Hercules) e Nitro 3200 (STB) conquistaram a cobiçada barra de 125 MHz.Apesar dos motivadores brutos e do desempenho medíocre contra o pano de fundo dos líderes das Três Grandes, o preço democrático de US $ 100 e a capacidade de reproduzir vídeos de alta qualidade permitiram que o S3 obtivesse boas vendas.

1997 e 1998 foram outro período de aquisições e falências - muitas empresas não aguentaram a concorrência na corrida pelo desempenho e foram forçadas a deixar o setor. Assim, Cirrus Logic, Macronix e Alliance Semiconductor foram deixados para trás, enquanto a Dynamic Pictures foi vendida para 3DLabs, Tseng Labs e Chromatic Research foram comprados pela ATI, Rendition deixou a Micron, AccelGraphics adquiriu Evans & Sutherland e Chips and Technologies tornou-se parte da Intel.

Trident, S3 e SiS - A batalha final do milênio por gráficos de orçamento

O mercado OEM sempre foi a gota d'água para os fabricantes que ficaram irremediavelmente atrás da concorrência em gráficos 3D e desempenho absoluto. Esse também foi o caso da SiS, que liberou o orçamento de SiS 300 para as necessidades do setor empresarial. Apesar do desempenho 3D deplorável (limitado por um único pipeline de pixel) e um atraso 2D sem esperança atrás de todos os concorrentes no mercado principal, o SiS 300 conquistou OEMs com certas vantagens - um barramento de memória de 128 bits (64 bits no caso do SiS 305 mais simplificado), suporte para cores de 32 bits, DirectX 6.0 (e até 7.0 no caso do 305), suporte para renderização multi-textura e decodificação MPEG2 por hardware. Havia uma placa gráfica e uma saída de TV.

Em dezembro de 2000, o SiS 315 modernizado viu a luz, que tem um segundo pipeline de pixel e um barramento de 256 bits, bem como suporte total para DirectX 8.0 e anti-aliasing de tela cheia. A placa recebeu um novo mecanismo de processamento de iluminação e textura, compensação para atrasos na reprodução de vídeo da mídia de DVD e suporte para o conector DVI. O nível de desempenho estava na região da GeForce 2 MX 200, mas isso não incomodou a empresa em nada.

O SiS 315 também entrou no mercado OEM, mas já como parte do chipset SiS 650 para placas-mãe no soquete 478 (Pentium IV) em setembro de 2001, e também como parte do sistema SiS552 SoC em 2003.

Mas a SiS estava longe de ser o único fabricante a oferecer soluções interessantes no segmento de orçamento. A Trident também lutou pela atenção dos compradores com o Blade 3D, cujo desempenho geral estava no mesmo nível do Intel i740 falido, mas o preço de US $ 75 mais do que cobriu muitas das deficiências. Mais tarde, o Blade 3D Turbo entrou no mercado, no qual as frequências aumentaram de 110 para 135 MHz, e o desempenho geral atingiu o nível de i752. Infelizmente, a Trident demorou muito para desenvolver suas soluções para o mercado, onde novos produtos eram apresentados a cada dois meses, então já em abril de 2000 isso desferiu o primeiro golpe para a empresa - VIA, para a qual a Trident estava desenvolvendo gráficos integrados, adquiriu a empresa S3 e interrompeu a cooperação com a anterior parceiro.

No entanto, a Trident alavancou seu modelo de negócios ao máximo, combinando remessas a granel e baixos custos de fabricação para suas soluções de orçamento. O setor móvel permaneceu relativamente vago, e a Trident desenvolveu vários modelos Blade3D Turbo especificamente para ele - o T16 e T64 (operando a 143 MHz) e o XP (operando a 165 MHz). Mas o mercado OEM que atraía muitas empresas não apoiava mais a simplicidade do Trident - o SiS 315, lançado um pouco mais tarde, dava um cheque e xeque-mate a toda a linha de produtos Trident. Incapaz de desenvolver rapidamente uma alternativa viável, a Trident decidiu vender a divisão gráfica para a subsidiária XGI da SiS em 2003.

O S3 Savage4 se destacou entre outras soluções no setor de orçamento. Anunciado em fevereiro e colocado à venda em maio de 1999, o novo produto oferecia 16 e 32 MB de memória on-board, um barramento AGP de quatro canais de 64 bits e sua própria tecnologia de compressão de textura, graças à qual o adaptador podia processar blocos com resoluções de até 2048x2048 sem muita dificuldade (embora isso e foi implementado anteriormente no Savage3D). A placa também era capaz de renderização multitextural, mas mesmo os drivers depurados e características técnicas impressionantes não conseguiam esconder o fato de que as ofertas do ano passado da 3Dfx, Nvidia e ATI foram significativamente mais produtivas. E este estado de coisas se repetiu um ano depois, quando o Savage 2000 entrou no mercado.Em baixas resoluções (1024x768 e menos), o novo produto poderia competir com Nvidia TNT e Matrox G400.mas quando uma resolução mais alta foi escolhida, o equilíbrio de poder mudou radicalmente.

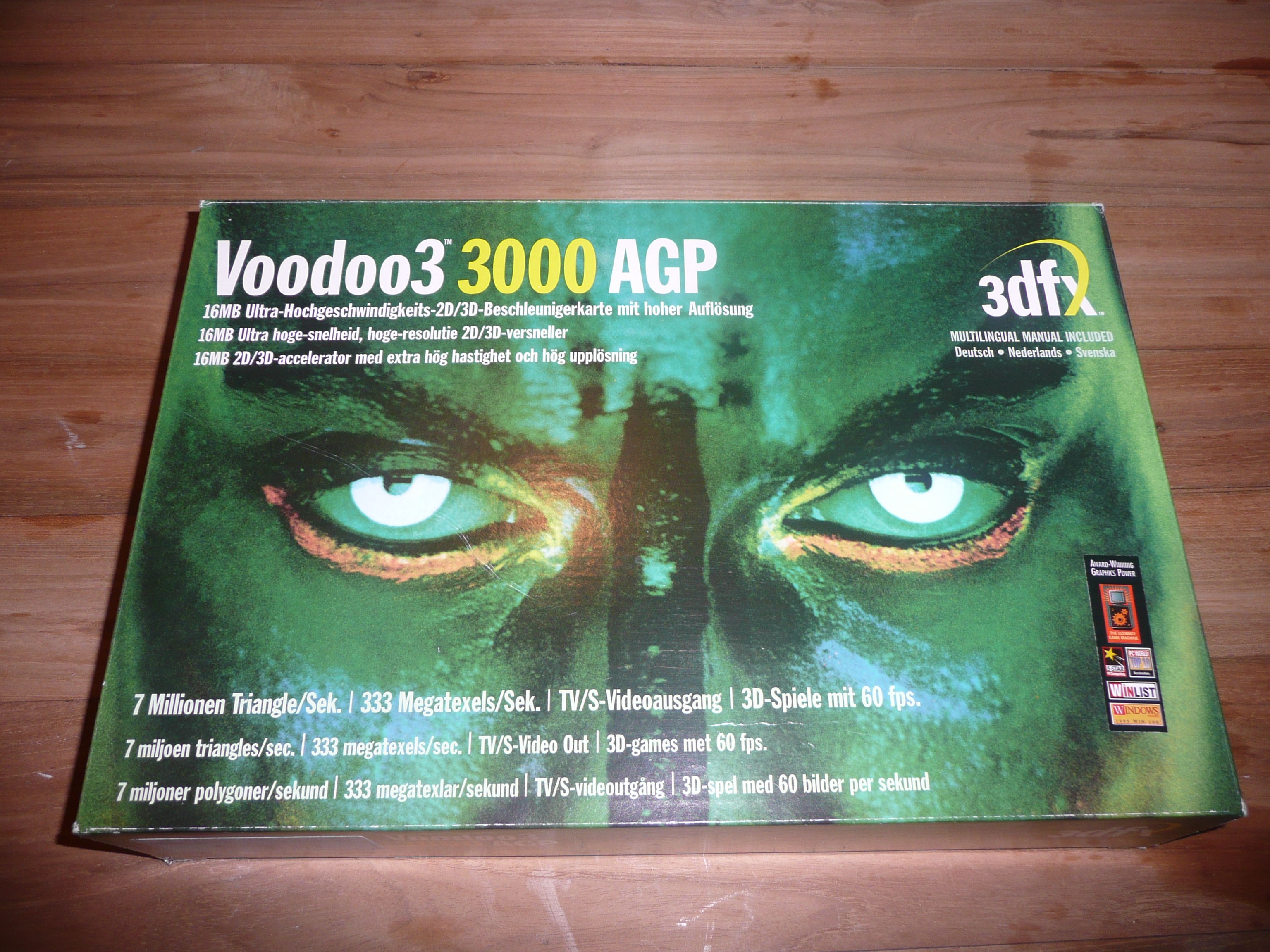

3Dfx Voodoo3 - Paphos, barulho e desculpas vazias

A 3Dfx não podia permitir que seu novo produto se perdesse no contexto de concorrentes progressistas, então a estréia de Voodoo3 em março de 1999 foi acompanhada por uma extensa campanha publicitária - o cartão foi vivamente promovido na imprensa e na televisão, e o design arrojado da caixa atraiu os olhos de compradores potenciais que sonhavam com uma nova revolução gráfica.

Infelizmente, o chipset Rampage, que se tornou o assunto da cidade, ainda não estava pronto, e a novidade arquitetônica era parente do Voodoo2 baseado no chip Avenger. Tecnologias arcaicas como suporte exclusivamente para cores de 16 bits e resolução de textura de apenas 256x256 não agradaram os fãs da marca, assim como a total falta de suporte para processamento de hardware de iluminação e geometria. Muitos fabricantes já introduziram uma moda para texturas de alta resolução, renderização multi-poligonal e cores de 32 bits, então pela primeira vez a 3dfx estava entre os retardatários em todos os aspectos.

Os investidores tiveram que explicar a perda de US $ 16 milhões com o recente terremoto em Taiwan, que, no entanto, teve pouco impacto no sucesso financeiro da ATI e da Nvidia. Percebendo os benefícios óbvios da distribuição gratuita de bibliotecas DirectX e OpenGL, a empresa anunciou em dezembro de 1998 que sua API Glide estaria disponível como código-fonte aberto. É verdade, naquela época, dificilmente havia muitas pessoas dispostas.

Riva TNT2 e G400 - concorrentes à frente

Simultaneamente com a estréia bombástica de Voodoo3 da 3Dfx, a Nvidia apresentou modestamente sua RIVA TNT 2 (com as primeiras placas da série Ultra em sua história, onde os jogadores receberam frequências de memória e núcleo mais altas), e a Matrox apresentou o G400 igualmente impressionante.

O Riva TNT2 foi fabricado com tecnologia de 250 nm nas fábricas da TSMC e foi capaz de fornecer à Nvidia um nível de desempenho sem precedentes. A novidade esmagou o Voodoo3 em quase todos os lugares - a única exceção foram alguns jogos que usavam o AMD 3DNow! Combinado com OpenGL. A Nvidia também acompanhou a tecnologia - a série TNT2 apresentou um conector DVI para suportar os mais recentes monitores de tela plana.

Uma verdadeira surpresa para todos foi o Matrox G400, que se revelou ainda mais produtivo que o TNT2 e o Voodoo3, ficando para trás apenas em jogos e aplicativos usando OpenGL. Por seu preço acessível de US $ 229, o novo produto da Matrox ofereceu excelente qualidade de imagem, desempenho invejável e a capacidade de conectar dois monitores por meio de um conector de cabeça dupla. O segundo monitor foi limitado a uma resolução de 1280x1024, mas muitas pessoas gostaram da ideia.

O G400 também possui Mapeamento de Bump Mapeado pelo Ambiente (EMBM) para melhorar a renderização geral da textura. Para quem sempre preferiu comprar a melhor, surgiu a G400 MAX, que detinha o título de placa mais produtiva do mercado até o lançamento da GeForce 256 com memória DDR no início de 2000.

Matrox Parhelia 3DLabs Permedia –

O grande sucesso no mercado de aceleradores gráficos de jogos não inspirou a Matrox, que voltou ao mercado profissional apenas uma vez tentada a repetir o sucesso do G400 com Parhelia, mas em 2002 os concorrentes já estavam dominando o DirectX 9.0 com poder e principal, e o suporte para três monitores ao mesmo tempo esmaeceu contra o pano de fundo de desempenho deplorável em jogos.

Quando o público já havia conseguido digerir os lançamentos em alto volume de três empresas, a 3DLabs apresentou o Permedia 3 Create! A principal característica da novidade era o posicionamento de nicho - a 3DLabs esperava atrair a atenção de profissionais que preferem passar o tempo livre em jogos. A empresa apostou na alta performance em 2D e atraiu especialistas da adquirida em 1998 Dynamic Pictures, criadores da linha profissional de adaptadores de Oxigénio.

Infelizmente para o 3DLabs, a modelagem de polígonos complexos era uma prioridade em mapas profissionais e, frequentemente, o alto desempenho nessa direção era fornecido por uma séria diminuição na velocidade de processamento de textura. Adaptadores de jogos com prioridade em 3D funcionavam exatamente ao contrário - em vez de cálculos complexos, a velocidade de renderização e as texturas de processamento com alta qualidade de imagem estavam em primeiro lugar.

Muito atrás do Voodoo3 e do TNT 2 em jogos, e não muito atrás da concorrência em aplicativos e tarefas de trabalho, o Permedia foi a última tentativa da 3DLabs de trazer um produto para o mercado de adaptadores de jogos. Além disso, os famosos engenheiros gráficos continuaram a expandir e apoiar suas linhas especializadas - GLINT R3 e R4 na arquitetura Oxygen, onde a abundância de modelos variava do orçamento VX-1 por $ 299 até o GVX 420 premium por $ 1499.

O repertório da empresa também incluiu a linha de adaptadores Wildcat, com base nos desenvolvimentos da Intense3D, adquirida da Integraph em julho de 2000. Em 2002, enquanto a 3DLabs estava ativamente concluindo o desenvolvimento de chips gráficos avançados para os novos adaptadores Wildcat, a empresa foi adquirida pela Creative Technology com seus planos para as linhas P9 e P10.

Em 2006, a empresa deixou o mercado de desktops, focando em soluções para o mercado de mídia, e posteriormente passou a fazer parte do Creative SoC, passando a se chamar ZiiLab. A história do 3DLabs finalmente terminou em 2012, quando a empresa foi comprada pela Intel.

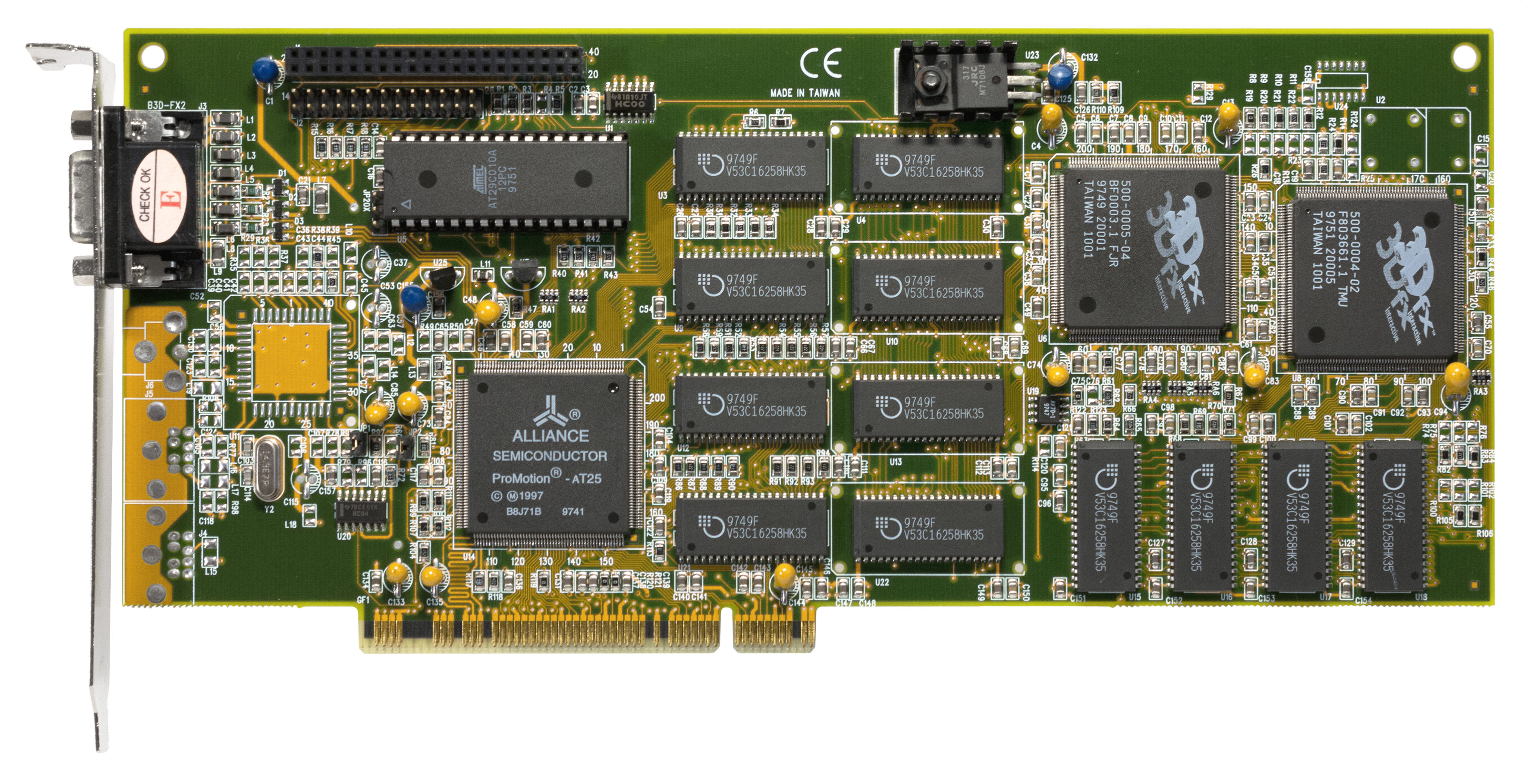

ATI Rage MAXX - Dual-Chip Madness Lagging

Desde o lançamento do sucesso Rage 128, a ATI passou por uma série de dificuldades com o desenvolvimento da linha. No final de 1998, os engenheiros implementaram com sucesso o suporte para o barramento AGP 4x em uma versão atualizada do adaptador Rage 128 Pro, adicionando uma saída de TV ao número de conectores. Em geral, o chip gráfico se mostrou aproximadamente ao nível do TNT 2 em termos de desempenho de jogo, mas após o lançamento do TNT 2 Ultra, o campeonato novamente passou para a Nvidia, que os canadenses não quiseram aturar - o trabalho no Projeto Aurora começou.

Quando ficou claro que a corrida pelo desempenho estava perdida, os engenheiros recorreram a um truque que se tornará um dos recursos de muitas gerações de cartões vermelhos no futuro - eles lançaram a Rage Fury MAXX, uma placa de vídeo de chip duplo, na qual dois Rage 128 Pros eram ligados.

Rage Fury MAXX

Especificações impressionantes e a possibilidade de operação paralela de dois chips tornaram a placa de nome odioso uma solução bastante produtiva, e trouxeram a ATI para frente, não foi possível manter a liderança por muito tempo. Mesmo o S3 Savage 2000 lutou pelo título de melhor, e a GeForce 256 com memória DDR apresentada posteriormente não deixou o carro-chefe da ATI qualquer chance - apesar dos números ameaçadores e das tecnologias progressivas. A Nvidia gostava de ser a primeira e a jovem Jen-Hsun Huang não tinha pressa em ceder ao líder de mercado.

GeForce 256 é a primeira verdadeira "placa de vídeo". O nascimento do termo GPU

Menos de dois meses se passaram desde que a ATI obteve uma vitória de Pirro nos benchmarks com o anúncio do Rage Fury MAXX, quando a Nvidia apresentou a resposta que garantiu o status de líder de mercado - a GeForce 256. A novidade foi a primeira na história a lançar diferentes tipos de memória de vídeo - 1º de outubro de 1999 Uma versão com chips SDR viu a luz do dia e, em 1º de fevereiro de 2000, começaram as vendas de uma versão atualizada com memória DDR.

GeForce 256 DDR

Um chip gráfico de 23 milhões de transistores foi fabricado nas fábricas da TSMC usando uma tecnologia de processo de 220 nm, mas mais importante, foi o GeForce 256 que se tornou o primeiro adaptador gráfico a ser chamado de "placa de vídeo". Você notou como evitamos cuidadosamente esse termo ao longo da história? Esse era o objetivo das substituições estranhas. O termo GPU (Unidade de Processamento Gráfico) vem da integração de pipelines de textura e iluminação previamente separados como parte do chip.

Os amplos recursos da arquitetura permitiram que o chip gráfico da placa de vídeo executasse cálculos pesados de ponto flutuante, transformando matrizes complexas de objetos 3D e cenas compostas em uma bela apresentação 2D para o jogador impressionado. Anteriormente, todos esses cálculos complexos eram realizados pelo processador central do computador, o que servia como uma séria limitação de detalhes em jogos.

O status da GeForce 256 como pioneira no uso de sombreadores de software com suporte para tecnologia de transformação e iluminação (T&L) tem sido frequentemente questionado. Outros fabricantes de aceleradores gráficos já implementaram suporte T&L em protótipos (Rendition V4400, BitBoys Pyramid3D e 3dfx Rampage), ou no estágio de algoritmos brutos, mas viáveis (3DLabs GLINT, Matrox G400), ou como uma função implementada por um chip adicional na placa (processador de geometria Fujitsu a bordo do Hercules Thriller Conspiracy).

No entanto, nenhum dos exemplos acima trouxe a tecnologia para o estágio comercial. A Nvidia foi pioneira em transformação e iluminação como uma vantagem arquitetônica do chip, dando à GeForce 256 essa vantagem competitiva e abrindo um mercado profissional anteriormente cético para a empresa.

E o interesse dos profissionais foi recompensado - apenas um mês após o lançamento das placas de vídeo para jogos, a NVidia apresentou as primeiras placas de vídeo da linha Quadro - os modelos SGI VPro V3 e VR3. Como você pode imaginar pelo nome, as placas foram desenvolvidas usando tecnologias proprietárias da SGI, um acordo com o qual a Nvidia firmou no verão de 1999. Ironicamente, um pouco mais tarde a SGI tentou processar a Nvidia por seu desenvolvimento, mas falhou, estando à beira da falência.

A Nvidia encerrou o último ano financeiro do milênio de saída de forma brilhante - lucro de $ 41,3 milhões em um faturamento total de $ 374,5 milhões. Em comparação com 1998, o lucro aumentou em uma ordem de magnitude e o faturamento total mais que dobrou. A cereja do bolo para Jensen Huang foi um contrato de US $ 200 milhões com a Microsoft, sob o qual a NVidia desenvolveu o chip NV2 (um núcleo gráfico para o futuro console Xbox), aumentando os ativos totais da empresa para US $ 400 milhões quando se tornou público em abril de 2000.

Claro, em comparação com os US $ 1,2 bilhão em faturamento da ATI e US $ 156 milhões em lucro líquido, os números do concorrente em crescimento pareciam modestos, mas o fabricante canadense de placas de vídeo não descansou sobre os louros, porque os contratos generosos do mercado OEM estavam sob ameaça devido ao lançamento dos gráficos progressivos integrados da Intel - o chipset 815.

... E adiante estava a queda dos grandes. E o início de uma nova era na corrida pelo desempenho.

O autor do texto é Alexander Lis.

Continua ... Lista de

reprodução Graphic Wars no YouTube: