Muitas vezes acontece que os data centers aparentemente ocultos são a espinha dorsal da nossa Internet. Eles transportam, armazenam e transmitem as informações que criamos todos os dias.

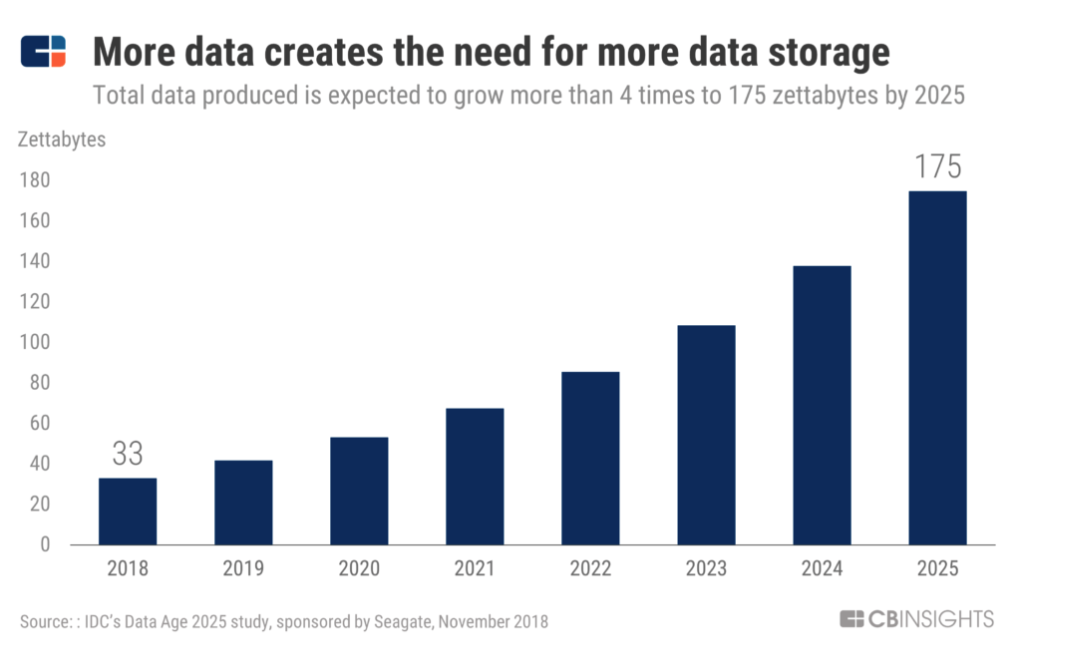

Quanto mais dados criamos, mais centros de dados vitais se tornam.

Hoje, muitos data centers são inadequados, não eficientes e desatualizados. Para mantê-los operacionais, os operadores de data center, da FAMGA aos centros de colocation, estão trabalhando para atualizá-los para atender às tendências de um mundo em constante mudança.

Neste relatório, abordamos muitos aspectos do futuro dos centros de informações e sua evolução. Começando de onde e como eles são criados, que energia eles usam e que hardware roda dentro deles.

Localização

O acesso por fibra ótica, tarifas para fontes de energia e meio ambiente desempenham um papel importante na escolha de um local para um data center.

Segundo algumas estimativas, o mercado global de construção de data centers em 2025 poderá chegar a US $ 57 bilhões. Isso é um grande desafio, uma vez que a gigante imobiliária comercial CBRE lançou uma divisão inteira dedicada aos data centers

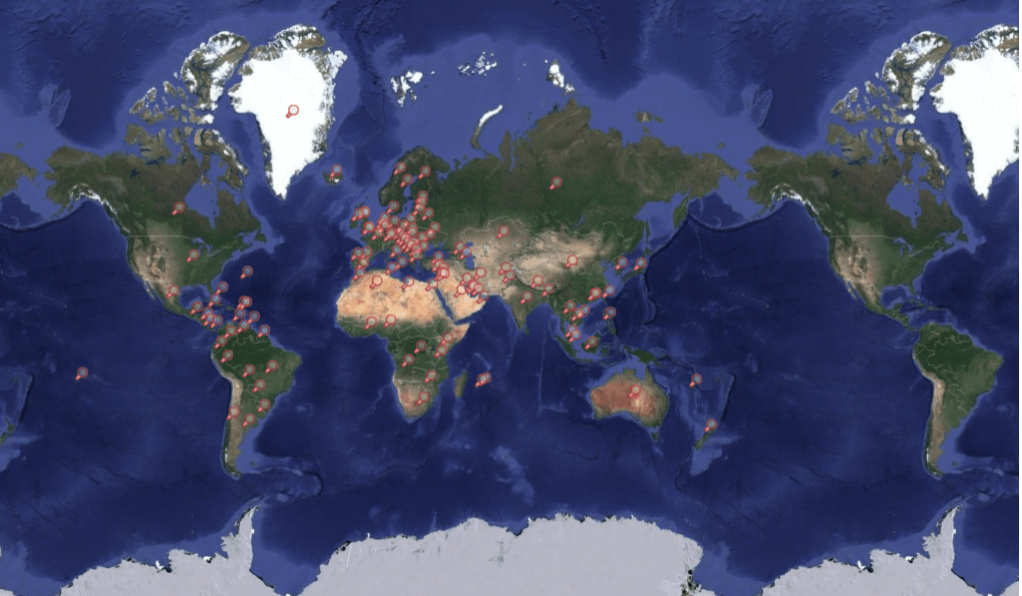

Mapa dos data centers

Construindo perto de fontes de energia baratas

A colocação de data centers com muita energia ao lado de fontes de energia baratas pode torná-los mais acessíveis para a execução. À medida que as emissões aumentam e as grandes empresas de tecnologia usam cada vez mais energia suja para alimentar data centers, as fontes de energia verde são um fator importante.

Apple e Facebook construíram data centers próximos aos recursos hidrelétricos. No centro de Oregon, a Apple adquiriu um projeto hidrelétrico para fornecer energia verde ao seu data center de Princeville. A empresa disse que os mercados desregulamentados de eletricidade do Oregon são a principal razão pela qual eles construíram vários data centers na área. A desregulamentação permite que a Apple compre eletricidade diretamente de fornecedores terceirizados que usam fontes de energia renováveis, não apenas as concessionárias locais.

Em Luleå, Suécia, o Facebook construiu um megacenter de dados próximo a uma usina hidrelétrica. Na Suécia, os data centers começaram a aparecer na região norte, pois, além do clima frio e a localização não é propensa a terremotos, nesta parte existem muitas fontes de energia renováveis (energia hidrelétrica e eólica).

Construção do Facebook em Luleå, Suécia em 2012. Fonte: Facebook

Vários grandes data centers já se mudaram para a Região Norte, alguns estão apenas de olho nele.

Em dezembro de 2018, a Amazon Web Services anunciou a abertura de seu data center da AWS Europe Region, localizado a cerca de uma hora de carro de Estocolmo. No mesmo mês, a Microsoft adquiriu 130 hectares de terra em duas partes vizinhas da Suécia, em Gavle e Sandviken, com o objetivo de construir data centers no local.

Além de estarem próximas de fontes de energia limpas e baratas, as empresas de data center também estão observando o clima frio. Locais próximos ao Círculo Polar Ártico, como o norte da Suécia, podem permitir que os data centers economizem em custos de refrigeração.

A empresa de telecomunicações Altice Portugal diz que seu data center da Covilhã usa ar externo para resfriar seus servidores em 99%. E o antigo data center do Google em Hamina, na Finlândia, usa água do mar do Golfo da Finlândia para resfriar a instalação e reduzir o consumo de energia.

A Verne Global abriu um campus na Islândia que se conecta a fontes geotérmicas e hidrelétricas locais. Está localizado em uma antiga base da OTAN e fica entre a Europa e a América do Norte, os dois maiores mercados de dados do mundo.

Construção em economias emergentes

A colocação de um data center em um ponto crescente de tráfego da Internet reduz a carga e aumenta a taxa de transferência de dados na região.

Por exemplo, em 2018, a empresa chinesa Tencent, dona do Fortnite e do WeChat, instalou data centers em Mumbai. Esta etapa se tornou um sinal de que a região está usando ativamente a Internet e as plataformas de jogos da Tencent estão se tornando cada vez mais populares.

A construção de data centers em áreas intensivas na Internet também é uma jogada estratégica de negócios. Se as empresas locais crescerem, elas considerarão mudar suas operações para o data center mais próximo.

Além disso, os data centers têm uma função de colocação. Isso significa que eles fornecem ao edifício refrigeração, energia, largura de banda e segurança física e, em seguida, concedem espaço aos clientes que instalam seus servidores e armazenamento no local. O serviço de localização geralmente se concentra em empresas com pequenas necessidades, além de ajudar as empresas a economizar dinheiro em infraestrutura.

Incentivos fiscais e leis locais

Os data centers são uma nova fonte de renda importante para os produtores de eletricidade e, portanto, o estado atrai grandes empresas com vários benefícios.

A partir de janeiro de 2017, o governo sueco reduziu o imposto em 97% sobre qualquer eletricidade usada pelos data centers. A eletricidade na Suécia é relativamente cara e os cortes de impostos colocam a Suécia em pé de igualdade com outros países escandinavos.

Em dezembro de 2018, o Google negociou uma isenção de impostos para a venda de um data center em New Albany, Ohio, por um período de 100% durante 15 anos, para um data center de US $ 600 milhões. Em setembro de 2018, a França, depois do Brexit que esperava atrair talento econômico e capital global, anunciou planos para reduzir os impostos sobre o consumo de eletricidade para os data centers.

Em alguns casos, a criação de um centro de armazenamento e processamento de dados é uma das maneiras pelas quais as empresas podem continuar operando em países com um regime estrito.

Em fevereiro de 2018, a Apple começou a armazenar dados em um local central em Guizhou, China, para cumprir com os regulamentos locais. Anteriormente, as autoridades chinesas tinham que usar o sistema jurídico dos EUA para acessar informações de cidadãos chineses armazenados no data center dos EUA, mas agora o data center local fornece às autoridades chinesas acesso mais fácil e rápido às informações dos cidadãos chineses armazenados na nuvem da Apple .

Enquanto as autoridades chinesas anteriormente tinham que passar pelo sistema jurídico dos EUA para obter acesso às informações dos cidadãos chineses armazenados no data center dos EUA, o data center local oferece às autoridades acesso mais fácil e rápido às informações sobre os cidadãos chineses armazenados na nuvem da Apple.

Conectividade e segurança de fibra óptica

Outros dois fatores críticos quando se trata de locais de data center são conectividade por fibra e segurança forte.

Por muitos anos, as redes de fibra ótica têm sido um fator-chave na seleção de locais de data center. Embora os dados sejam frequentemente transmitidos para dispositivos móveis por redes sem fio ou Wi-Fi local.

Na maioria das vezes, os dados são movidos para e do armazenamento por meio de cabos de fibra óptica. A fibra óptica conecta os datacenters a antenas celulares, roteadores domésticos e outros dispositivos de armazenamento.

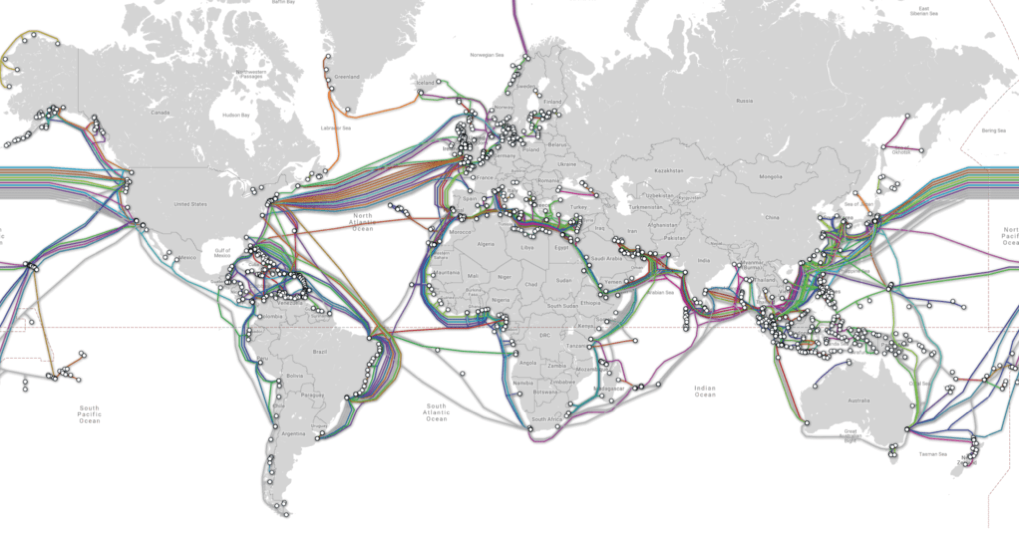

Mapa de cabos submarinos

Ashburn, Virgínia e regiões vizinhas cresceram em um grande mercado de data centers, em grande parte graças à grande rede de infraestrutura de fibra óptica que a AOL lançou como sede. Enquanto outras empresas, como a Equinix, se mudaram para a região e construíram seus próprios data centers, as redes de fibra da região continuam a crescer, atraindo cada vez mais novos data centers.

O Facebook investiu quase US $ 2 bilhões em um data center em Henrico, Virgínia, e em janeiro de 2019, a Microsoft recebeu uma doação de US $ 1,5 milhão pela sexta vez para expandir seu data center em Southside, Virgínia.

Novas alternativas para redes de fibra óptica também estão surgindo à medida que grandes técnicos constroem sua própria infraestrutura de conexão.

Em maio de 2016, o Facebook e a Microsoft anunciaram um trabalho conjunto de cabos submarinos entre Virginia Beach, Virginia e Bilbao, Espanha. Em 2017, o Facebook anunciou mais planos para construir sua própria rede de fibra subterrânea de 300 quilômetros em Las Lunas, Novo México, para conectar seu data center no Novo México a outros farms de servidores. O sistema subterrâneo de fibra ótica criará três rotas em rede exclusivas para a viagem de informações a Las Lunas.

Além da conectividade, outro ponto importante é a segurança. Isso é especialmente importante para data centers que armazenam informações confidenciais.

Por exemplo, o gigante financeiro norueguês DNB, em parceria com o data center de Green Mountain, criou seu próprio data center. A Green Mountain abrigou o data center da DNB em uma instalação de segurança aprimorada, um bunker convertido em uma montanha. A empresa afirma que a montanha está completamente protegida de todos os tipos de riscos, incluindo ataques terroristas, erupções vulcânicas, tempestades e terremotos.

O data center suíço de Fort Knox está localizado sob os Alpes suíços, com uma porta disfarçada de pedra. Seu complexo sistema interno inclui muitos túneis que só podem ser acessados com a limpeza apropriada. O data center é protegido por motores a diesel de emergência e um sistema de pressão de ar que impede a entrada de gases tóxicos na sala.

O Knox Fort da Suécia é fisicamente e digitalmente hiper-seguro. Fonte: Mount 10

Devido ao alto grau de segurança do servidor em alguns data centers, existem muitos data centers cujos locais nunca foram anunciados. As informações de localização desses centros podem ser usadas como uma arma.

Em outubro de 2018, o WikiLeaks publicou uma Lista de Objetos da AWS interna. Entre as informações vazadas, estava o fato de a Amazon ser uma licitante para construir uma nuvem privada no valor de cerca de US $ 10 bilhões para o Departamento de Defesa.

O próprio WikiLeaks enfrentou dificuldades em encontrar um data center adequado para hospedar suas informações. A AWS parou de hospedar o WikiLeaks porque a empresa violou os termos de serviço - ou seja, lançou documentos aos quais não tinha direitos e colocou as pessoas em risco.

Como resultado, o WikiLeaks mudou-se para muitos centros de dados diferentes. A certa altura, havia até boatos de que o WikiLeaks estava pensando em colocar seu data center no oceano, no estado não reconhecido de Sealand no Mar do Norte.

Estrutura

Embora a localização seja indiscutivelmente o fator mais importante na redução do risco de interrupção do data center, as estruturas do data center também desempenham um papel importante em garantir confiabilidade e longevidade.

A construção adequada do data center pode torná-lo resistente a atividades sísmicas, inundações e outros tipos de desastres naturais. Além disso, as estruturas podem ser adaptadas para expansão, reduzindo os custos de energia.

Em todos os setores - de assistência médica a finanças e manufatura - as empresas contam com data centers para oferecer suporte ao crescente consumo de dados. Em alguns casos, esses data centers podem ser proprietários e localizados no local, enquanto outros podem ser compartilhados e localizados remotamente.

De qualquer maneira, os data centers estão no coração de um mundo tecnológico crescente e continuam a experimentar suas próprias transformações físicas. De acordo com a ferramenta CB Insights Market Sizing, o mercado global de serviços de data center está avaliado em US $ 228 bilhões até 2020.

Uma das transformações mais recentes na construção do data center é o tamanho. Alguns data centers se tornaram menores e mais difundidos (eles são chamados de data centers de ponta). Ao mesmo tempo, outros data centers se tornaram cada vez mais centralizados do que nunca - são mega data centers)).

Nesta seção, veremos os centros de dados e mega-data.

Data centers periféricos

Pequenos data centers distribuídos, chamados edge data centers, são criados para fornecer armazenamento hiperlocal.

Enquanto a computação em nuvem tradicionalmente serviu como um meio confiável e econômico de conectar muitos dispositivos à Internet, o crescimento contínuo da IoT e da computação móvel pressionou a largura de banda das redes de data center.

Agora, a computação de borda está surgindo para oferecer uma solução alternativa. (A computação em borda é um paradigma da computação distribuída que está ao alcance dos dispositivos finais. Esse tipo de computação é usado para reduzir o tempo de resposta da rede e usar a largura de banda da rede com mais eficiência.)

Isso envolve colocar os recursos de computação mais perto de onde os dados vêm (por exemplo, mecanismos, geradores ou outros elementos. Ao fazer isso, reduzimos o tempo necessário para mover dados para locais de computação centralizados, como nuvens.

Embora essa tecnologia ainda esteja em sua infância, já fornece um método mais eficiente de processamento de dados para vários casos de uso, incluindo veículos autônomos. Por exemplo, os veículos Tesla possuem computadores de bordo poderosos que podem processar dados com baixa latência (quase em tempo real) para dados coletados por dezenas de sensores periféricos no carro. permite que o carro tome decisões independentes em tempo hábil.)

No entanto, outras tecnologias avançadas, como dispositivos médicos sem fio e sensores, não possuem o poder de computação necessário para processar diretamente grandes fluxos de dados complexos.

Como resultado, centros de dados modulares menores estão sendo implantados para fornecer armazenamento hiperlocal e processamento de dados. De acordo com a ferramenta CB Insights Market Sizing, o mercado global de computação chegará a US $ 34 bilhões até 2023.

Esses data centers, normalmente do tamanho de um contêiner de remessa, estão localizados na base das torres de células ou o mais próximo possível da fonte de dados.

Além de transporte e assistência médica, esses data centers modulares são usados em setores como manufatura, agricultura, energia e serviços públicos. Eles também estão ajudando as operadoras de rede móvel (MNS) a fornecer conteúdo aos assinantes móveis mais rapidamente, enquanto muitas empresas de tecnologia usam esses sistemas para armazenar (ou armazenar em cache) o conteúdo mais próximo de seus usuários finais.

O Vapor IO é uma das empresas que oferece serviços de colocation, hospedando pequenos data centers baseados em torres de celular. A empresa possui uma parceria estratégica com a Crown Castle, o maior provedor de infraestrutura sem fio nos Estados Unidos.

Outras empresas líderes de data center, como a Edgemicro, fornecem centros de microdados que conectam operadoras de rede móvel (MNCs) a provedores de conteúdo (CPSs). Os fundadores da EdgeMicro se baseiam na experiência de líderes de organizações como a Schneider Electric, uma das maiores empresas de energia da Europa, e a CyrusOne, uma das maiores e mais bem-sucedidas prestadoras de serviços de data center nos Estados Unidos.

A empresa lançou recentemente sua primeira unidade de produção e planeja vender seus serviços de colocation a provedores de conteúdo como Netflix e Amazon, que se beneficiarão de maior velocidade e confiabilidade na entrega de conteúdo. Esses serviços de colocation são ideais para empresas que desejam possuir, mas não gerenciar sua infraestrutura de dados.

Edge micro

E as startups não são as únicas envolvidas no mercado de data center periférico.

Grandes empresas como a Schneider Electric, não apenas colaboram com as startups, mas também desenvolvem seus próprios produtos para data centers. A Schneider oferece vários data centers modulares pré-fabricados diferentes, ideais para vários setores que exigem recursos de computação hiper-locais e espaço de armazenamento.

Huawei

Essas soluções completas integram sistemas de energia, refrigeração, combate a incêndio, iluminação e controle em um único pacote. Eles foram projetados para implantação rápida, operação confiável e monitoramento remoto.

Megacentros de processamento de dados

No outro extremo do espectro estão os mega-data centers - data centers com uma área de pelo menos 1 milhão de metros quadrados. ft. Essas instalações são grandes o suficiente para atender às necessidades de dezenas de milhares de organizações ao mesmo tempo e se beneficiam enormemente de economias de escala.

Embora esses mega-centros sejam caros de construir, o custo por metro quadrado é muito maior que o custo de um data center médio.

Um dos maiores projetos é um objeto com uma área de 17,4 milhões de metros quadrados. ft. construído pela Switch Communications, que fornece às empresas alojamento, refrigeração, energia, largura de banda e segurança física para seus servidores.

Interruptor

Além deste imenso campus da Citadel em Tahoe Reno, a empresa também possui um data center com uma área de 3,5 milhões de metros quadrados. pés em Las Vegas, um campus de 1,8 milhão de metros quadrados ft em Grand Rapids e um milhão de metros quadrados. pés em Atlanta. O campus da Citadel é o maior data center de colocation do mundo, de acordo com o site da empresa.

A grande tecnologia também está construindo ativamente mega data centers nos EUA, com Facebook, Microsoft e Apple - todos os edifícios para atender às crescentes necessidades de armazenamento de dados.

Por exemplo, o Facebook está construindo um data center com uma área de 2,5 milhões de metros quadrados. ft. em Fort Worth, Texas, para processar e armazenar dados pessoais de seu usuário. Supunha-se que o data center ocupasse apenas 750 mil metros quadrados. Pés, mas a empresa de mídia social decidiu triplicar seu tamanho.

Fonte: Facebook

O novo data center custará cerca de US $ 1 bilhão e estará localizado em um terreno de 150 acres, o que tornará possível a expansão no futuro. Em maio de 2017, foram comissionados 440 mil metros quadrados. Pés.

Um dos investimentos mais recentes da Microsoft é um data center em West Des Moines, Iowa, que custou à empresa US $ 3,5 bilhões. Juntos, esse cluster de data center ocupa 3,2 milhões de pés quadrados de espaço e o maior data center ocupa 1,7 milhão de pés quadrados. Este data center especial, chamado Projeto Osmium, está localizado em 200 acres de terra e deve ser concluído em 2022.

Nos últimos anos, Iowa se tornou um destino popular para data centers devido aos baixos preços de energia (alguns dos mais baixos do país) e ao baixo risco de desastres naturais.

A Apple também está construindo uma pequena instalação de 400.000 pés quadrados em Iowa, que custará US $ 1,3 bilhão.Fonte

: Apple Newsroom

Enquanto algumas instalações da Apple são construídas do zero para gerenciar todo o seu conteúdo - armazenamento de aplicativos, streaming de música serviço, armazenamento do iCloud, dados do usuário, a Apple reformou uma planta de painel solar de 1,3 m² em Mesa, Arizona, inaugurada em agosto de 2018. O novo data center funciona com 100% de energia verde, graças a uma fazenda solar nas proximidades.

Fora dos Estados Unidos, as regiões específicas que atraíram esses mega data centers incluem o norte da Europa, que era um destino popular para os gigantes da construção de tecnologia devido à sua temperatura baixa e aos incentivos fiscais.

Hohhot, China, localizada na Mongólia Interior, também possui uma localização conveniente para mega data centers, pois tem acesso a energia local barata, temperaturas baixas e talento universitário (com a Universidade da Mongólia Interior).

Enquanto os grandes data centers se tornaram um tópico popular para toda a China, a região da Mongólia Interior se tornou o centro de tais desenvolvimentos. A China Telecom (10,7 milhões de SF), a China Mobile (7,8 milhões de SF) e a China Unicom (6,4 milhões de SF) criaram mega data centers na região.

Fonte: Os principais data centers do mundo

Inovação em data center

Além dos data centers, novas estruturas de data center projetadas com benefícios ambientais em mente são outra tendência emergente.

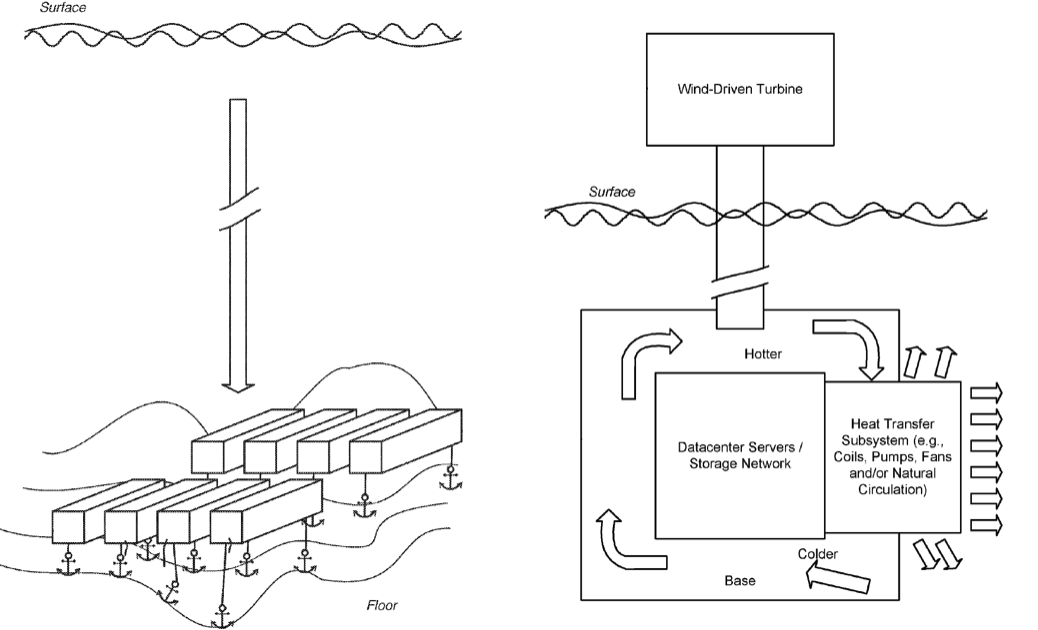

Hoje, muitas organizações estão experimentando data centers que operam dentro e ao redor do oceano. Essas estruturas usam seu ambiente e recursos para resfriar naturalmente os servidores a um custo muito baixo.

Um dos exemplos mais inovadores do uso do oceano de resfriamento livre é o Projeto Natick, da Microsoft. Conforme observado em um pedido de patente de 2014 chamado Submersible Data Center, a Microsoft submergiu um pequeno data center cilíndrico ao longo da costa da Escócia.

O data center usa 100% da eletricidade renovável produzida localmente a partir de fontes eólicas e solares costeiras, bem como de marés e ondas. A instalação usa o oceano para remover o calor da infraestrutura.

Fonte: Microsoft

Desde os primeiros estágios, a Microsoft fez grandes progressos nesse projeto, o que poderia fornecer sinal verde para a expansão do data center oceânico no futuro.

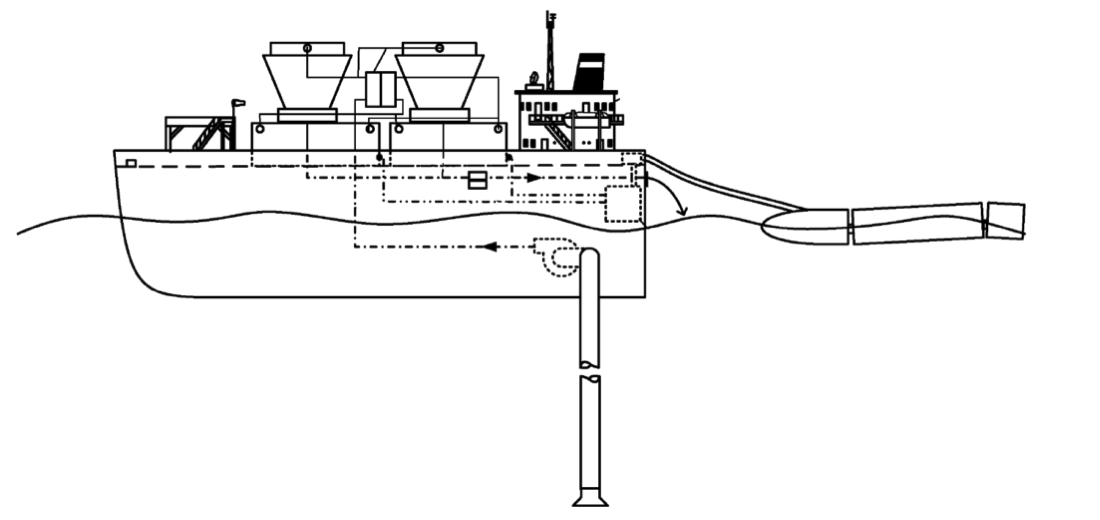

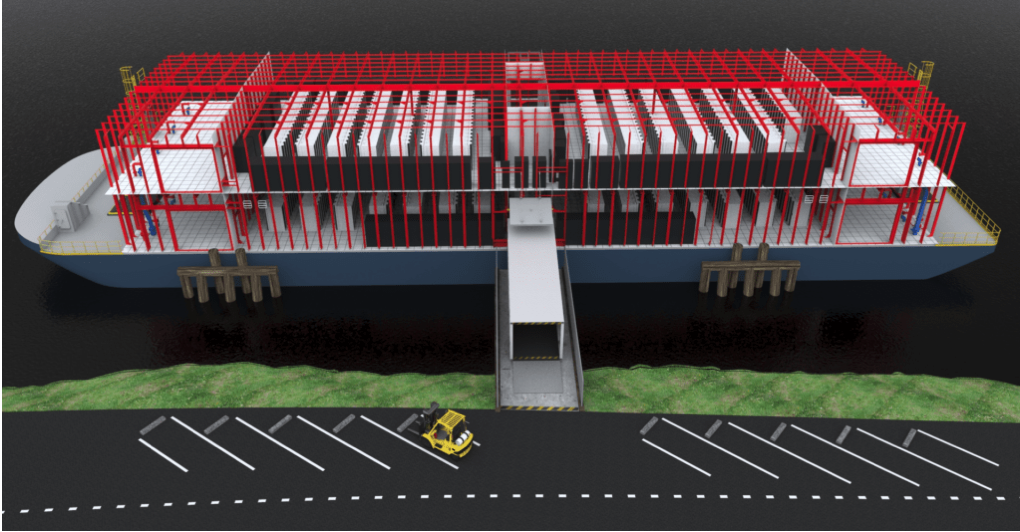

O Google também experimentou centros de dados oceânicos. Em 2009, a empresa entrou com um pedido de patente para um data center à base de água, que prevê a criação de data centers a bordo de barcaças flutuantes.

Semelhante ao design da Microsoft, a estrutura usará a água ao redor para resfriar naturalmente a instalação. Além disso, a barcaça também pode gerar energia a partir das correntes oceânicas.

Embora o Google não tenha divulgado se essas estruturas foram testadas, acredita-se que a empresa seja responsável por uma barcaça flutuante na Baía de São Francisco em 2013.

O lançamento da Nautilus Data Technologies seguiu uma idéia muito semelhante. Nos últimos anos, a empresa levantou US $ 58 milhões para dar vida ao conceito deste data center flutuante.

Fonte: Chefe de Negócios

A empresa está se concentrando menos no próprio navio e mais na tecnologia necessária para alimentar e resfriar os data centers. Os principais objetivos do Nautilus são: reduzir o custo da computação, reduzir o consumo de energia, eliminar o consumo de água, reduzir a poluição do ar e reduzir as emissões de gases de efeito estufa.

Eficiência e economia de energia

Atualmente, os data centers representam 3% de todo o consumo de eletricidade no mundo, e esse percentual só crescerá. Essa eletricidade nem sempre é "limpa": de acordo com as Nações Unidas (ONU), o setor de tecnologia da informação e comunicação (TIC), que é amplamente abastecido por data centers, fornece a mesma quantidade de gases de efeito estufa que o combustível para o setor de aviação.

Embora as TIC tenham conseguido conter o aumento do consumo de eletricidade, em parte, fechando datacenters antigos e ineficientes, essa estratégia só pode levar a um aumento no consumo da Internet e na produção de dados.

No futuro, existem duas opções para os data centers reduzirem as emissões: melhorar a eficiência energética dentro do data center e garantir o uso de energia limpa.

Reduzindo o consumo e aumentando a eficiência energética

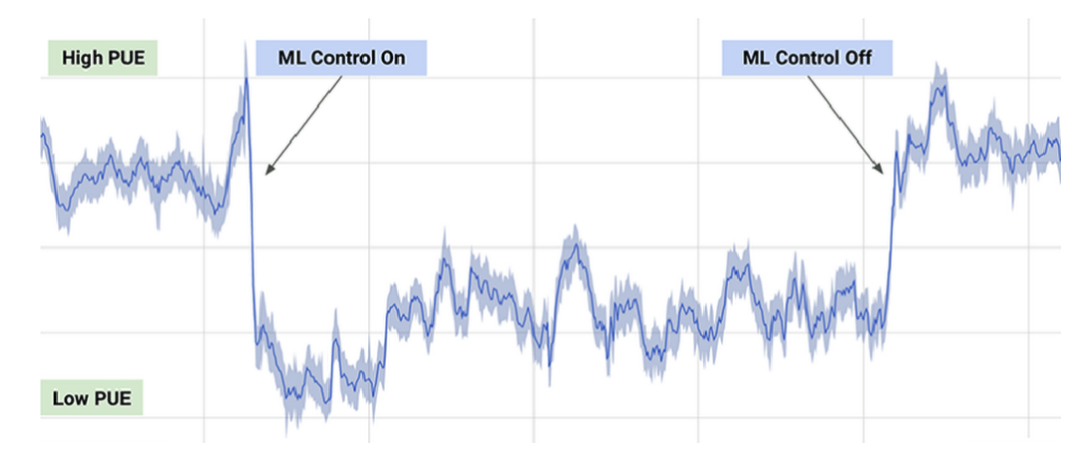

Em 2016, o DeepMind e o Google trabalharam em um sistema de recomendação de IA para ajudar a tornar os data centers do Google mais eficientes em termos de energia. O foco estava nas pequenas melhorias: até pequenas mudanças foram suficientes para ajudar a economizar energia significativa e reduzir as emissões. No entanto, depois que as recomendações foram postas em prática, sua implementação exigiu muito esforço do operador.

Os operadores de data center perguntaram se eles podem ser implementados de forma autônoma. No entanto, segundo o Google, nenhum sistema de inteligência artificial ainda está pronto para controlar totalmente os processos de refrigeração e aquecimento no data center.

O atual sistema de gerenciamento de IA do Google está trabalhando em ações específicas, mas só pode executá-las em condições limitadas, priorizando a segurança e a confiabilidade. Segundo a empresa, o novo sistema fornece uma média de até 30% de economia de energia.

Dia típico de PUE (eficiência energética) com ML ligado e desligado.

Fonte: DeepMind

O Google também usou um sistema de inteligência artificial para ajustar a eficiência de um data center no Centro-Oeste durante a vigilância de tornados. Embora o operador humano possa se concentrar na preparação para a tempestade, o sistema de IA aproveitou o conhecimento e o conhecimento das condições de tornados - como mudanças na pressão atmosférica e na temperatura e umidade - para ajustar os sistemas de refrigeração do datacenter para obter a máxima eficiência durante tornados. No inverno, o sistema de controle de IA se adapta às condições climáticas para reduzir o consumo de energia necessário para resfriar o data center.

No entanto, este método não deixa de ter suas desvantagens. As lacunas na tecnologia de IA tornam difícil para o centro tomar decisões efetivas com facilidade e a inteligência artificial é muito difícil de ser dimensionada. Cada um dos datacenters do Google é único e é difícil implantar a ferramenta de inteligência artificial (AI) de uma só vez.

Outra maneira de melhorar a eficiência é alterar a maneira como você resfria partes superaquecidas do data center, como servidores ou certos tipos de chips.

Um desses métodos é usar fluido em vez de ar para resfriar as peças. O CEO do Google, Sundar Pichai, disse que os chips lançados recentemente são tão poderosos que a empresa teve que mergulhá-los em líquidos para resfriá-los no grau desejado.

Alguns data centers estão experimentando submergir data centers para simplificar o resfriamento e melhorar a eficiência energética. Isso permite que os data centers tenham acesso constante à água do mar naturalmente fresca e fria, de modo que o calor do equipamento vá para o oceano ao redor. Como o data center pode ser localizado em qualquer costa, torna possível escolher uma conexão para energia limpa - como o Microsoft Project Natick, com 15 metros de comprimento, alimentado pelo vento da rede das Ilhas Órcades.

A vantagem que os data centers submarinos menores têm é que eles podem ser modulares. Isso simplifica sua implantação em comparação com os novos centros terrestres.

No entanto, apesar dessas vantagens, alguns especialistas desconfiam dos datacenters subaquáticos, pois as inundações são possíveis. Como o processo de resfriamento envolve captar água limpa e liberar água quente na região circundante, esses centros de dados podem aquecer o mar afetando a flora e fauna marinhas locais. E embora os data centers submarinos, como o Project Natick, sejam projetados para operar sem controle humano, se surgirem problemas, eles podem ser difíceis de corrigir.

No futuro, os data centers também podem contribuir para energia limpa e eficiência reciclando parte da eletricidade que geram. Alguns projetos já estão explorando a possibilidade de reutilizar o calor. O Northern Data Center DigiPlex está em parceria com a Stockholm Exergi, fornecedora de sistemas de aquecimento e refrigeração, para criar um sistema de recuperação de calor. O conceito desta solução é coletar excesso de calor no data center e enviá-lo ao sistema de aquecimento urbano local para potencialmente aquecer até 10.000 residentes de Estocolmo.

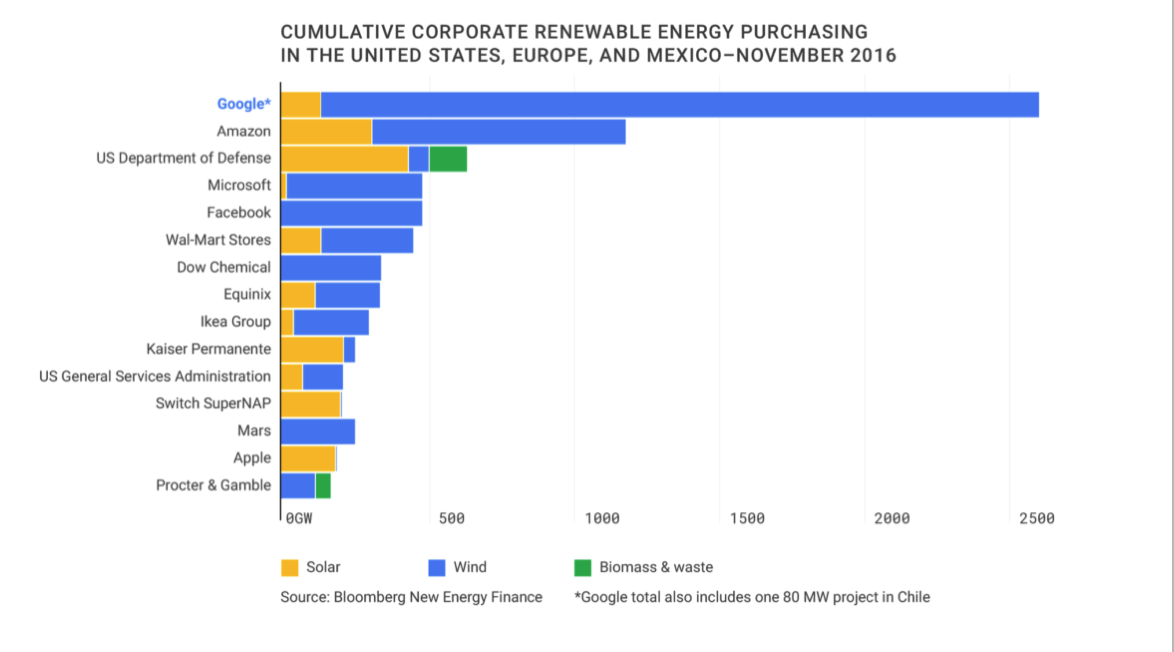

Compra de energia limpa

De acordo com a AIE, o setor de TIC fez alguns progressos no campo da energia limpa e atualmente está fechando quase metade de todos os acordos corporativos para a compra de eletricidade de fontes renováveis.

A partir de 2016, o Google é o maior comprador de energia renovável corporativa do planeta.

Fonte: Google Sustainability

Em dezembro de 2018, o Facebook adquiriu 200 MW de energia de uma empresa que produz energia solar. Em Cingapura, onde a área terrestre é limitada, o Google anunciou planos para comprar 60 MW de energia solar no telhado.

Ao mesmo tempo, grandes empresas como Google e Facebook, que têm recursos para comprar grandes quantidades de energia renovável, podem ser difíceis para pequenas empresas que podem não precisar de grandes quantidades de energia.

Outra opção de energia mais cara é o MicroGrid: instalar uma fonte de energia independente dentro do data center.

Um exemplo dessa estratégia são as células de combustível, semelhantes às vendidas recentemente pela empresa pública Bloom Energy. As células usam hidrogênio como combustível para criar eletricidade. Embora essas fontes alternativas sejam frequentemente usadas como energia de backup, o data center pode confiar inteiramente nesse sistema para sobreviver, embora seja uma opção economicamente cara.

Outra maneira de os centros de dados investigarem energia limpa é através do uso de fontes de energia renováveis (REC), que representam uma certa quantidade de energia limpa e geralmente são usadas para equilibrar a "energia suja" usada pela empresa. Para qualquer quantidade de energia suja produzida, o REC representa a produção de uma quantidade equivalente de energia limpa no mundo. Esses valores recuperados são então revendidos ao mercado de energia renovável.

No entanto, existem alguns problemas com o modelo REC. Por um lado, as CERs compensam apenas a energia suja - isso não significa que o data center esteja funcionando com energia limpa. Embora o método REC seja geralmente mais fácil do que encontrar fontes disponíveis que possam fornecer energia suficiente para atender às necessidades do data center. A desvantagem é que o método geralmente não está disponível para pequenas empresas que nem sempre têm capital para depender de flutuações em uma usina solar ou eólica.

No futuro, a tecnologia facilitará uma estreita colaboração entre pequenos produtores e compradores. Modelos e portfólios de mercados de energia renovável (semelhantes aos criados por fundos mútuos) estão surgindo para avaliar e quantificar as flutuações nas energias renováveis.

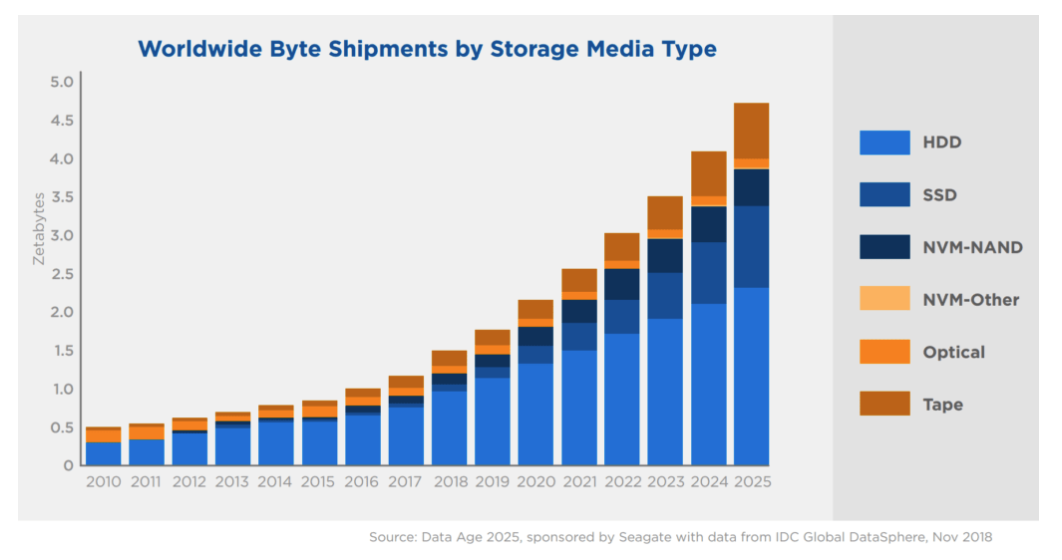

(SSD)

As unidades de estado sólido, ou SSDs, são um tipo de dispositivo de armazenamento que pode ler e gravar dados. Esses dispositivos podem armazenar dados sem energia - isso é chamado de armazenamento persistente. Isso difere das formas temporárias de armazenamento de dados, como RAM, que armazenam informações apenas durante a operação do dispositivo.

Os SSDs competem com os HDDs, outra forma de armazenamento em massa. A principal diferença entre SSD e HDD é que os SSDs funcionam sem partes móveis. Isso permite que os SSDs sejam mais duráveis e leves.

No entanto, os SSDs permanecem mais caros do que os HDDs tradicionais - uma tendência que provavelmente continuará sem um avanço na produção de unidades de estado sólido.

Fonte: Silicon Power Blog

E embora as unidades de estado sólido tenham se tornado o padrão para laptops, smartphones e outros dispositivos com um perfil fino, elas são menos práticas e, portanto, menos comuns em grandes data centers devido ao seu preço mais alto.

Fonte: Seagate e IDC

Segundo a IDC, até o final de 2025, mais de 80% do armazenamento corporativo permanecerá na forma de discos rígidos. Mas após 2025, os SSDs podem se tornar o meio de armazenamento preferido para empresas e seus data centers.

À medida que as unidades de estado sólido estão se tornando mais comuns em eletrônicos de consumo e dispositivos de IoT, o aumento da demanda pode levar a um fornecimento mais alto e, finalmente, a um custo menor.

Armazém frio

Ao contrário dos SSDs mais novos, o armazenamento a frio usa muitas tecnologias mais antigas, como CD-Rs e fitas magnéticas, para manter os dados usando o mínimo de energia possível.

No armazenamento a frio, o acesso aos dados leva muito mais tempo do que no armazenamento a quente (por exemplo, SSD). Esses sistemas devem armazenar apenas dados usados com pouca frequência.

As nuvens "quentes" executadas em unidades SSD e híbridas fornecem o acesso mais rápido às informações. O armazenamento a frio é uma solução mais econômica e mais lenta. Em "Cold Clouds", eles armazenam informações que não são necessárias para a familiarização instantânea. Após uma solicitação, os dados podem ser baixados de vários minutos a dezenas de horas.

E, literalmente, a diferença de temperatura dentro dos data centers é quanto mais rápida a nuvem, mais calor o equipamento gera.

No entanto, as maiores empresas de tecnologia do mundo, como Facebook, Google e Amazon, usam armazenamento a frio para armazenar até os dados mais granulares dos usuários. Provedores de nuvem como Amazon, Microsoft e Google também oferecem esses serviços para clientes que desejam armazenar dados a baixo custo.

De acordo com a CB Insights Market Calibration Tool, o mercado de armazenamento a frio deve atingir quase US $ 213 bilhões até 2025.

habrastorage.org/webt/cr/cc/t-/crcct-u3vtckequtnd0eazlwkqk.png

Fonte: IBM

Nenhuma empresa quer ficar atrás da curva na coleta de dados. A maioria das organizações argumenta que é melhor coletar o máximo de dados possível hoje, mesmo que ainda não tenha decidido como serão usados amanhã.

Este tipo de dados não utilizados é chamado de dados escuros. São dados coletados, processados e armazenados, mas geralmente não são usados para fins específicos. A IBM estima que aproximadamente 90% dos dados do sensor coletados da Internet nunca são usados.

No futuro, pode haver maneiras mais eficientes de reduzir a quantidade total de dados escuros coletados e armazenados. Atualmente, porém, mesmo com o desenvolvimento da inteligência artificial e do aprendizado de máquina, as empresas ainda estão interessadas em coletar e armazenar o máximo de dados possível, a fim de usá-los no futuro.

Portanto, em um futuro previsível, o melhor armazenamento a frio permite armazenar dados pelo menor preço. Essa tendência continuará à medida que os usuários gerarem mais dados e as organizações os coletarem.

Outras formas de armazenamento de dados

Além de unidades de estado sólido, discos rígidos, CDs e fitas magnéticas, estão surgindo várias novas tecnologias de armazenamento que prometem mais capacidade por unidade de armazenamento.

Uma das tecnologias promissoras é a gravação termomagnética (também gravação magnética térmica) ou HAMR. O HAMR aumenta significativamente a quantidade de dados que podem ser armazenados em dispositivos como discos rígidos, aquecendo a superfície do disco com um laser de alta precisão durante a gravação. Isso fornece gravação de dados mais precisa e estável, o que aumenta a capacidade de armazenamento.

Espera-se que, até 2020, essa tecnologia permita a produção de até 20 TB de discos rígidos em uma unidade de 3,5 polegadas e, no futuro, aumente anualmente a capacidade em 30% a 40%. A Seagate já criou uma unidade de 16TB e 3,5 polegadas, anunciada em dezembro de 2018.

A Seagate patenteou ativamente essa tecnologia HAMR na última década. Em 2017, a empresa registrou um número recorde de patentes relacionadas a essa tecnologia.

(Observação: há um atraso de 12 a 18 meses entre o registro e a publicação de patentes, portanto, 2018 poderá ter ainda mais patentes HAMR.)

Um pouco de publicidade :)

Obrigado por ficar com a gente. Você gosta dos nossos artigos? Deseja ver conteúdo mais interessante? Ajude-nos fazendo um pedido ou recomendando aos seus amigos o VPS na nuvem para desenvolvedores a partir de US $ 4,99, um analógico exclusivo de servidores de nível básico que foi inventado por nós para você: Toda a verdade sobre o VPS (KVM) E5-2697 v3 (6 núcleos) 10GB DDR4 480GB SSD 1Gbps de 10GB de US $ 19 ou como dividir o servidor corretamente? (as opções estão disponíveis com RAID1 e RAID10, até 24 núcleos e até 40GB DDR4).

O Dell R730xd é 2x mais barato no data center Equinix Tier IV em Amsterdã? Somente temos 2 TVs Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV a partir de US $ 199 na Holanda! Dell R420 - 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB - a partir de $ 99! Ler sobre . c Dell R730xd 5-2650 v4 9000 ?