Cientistas britânicos treinaram IA para transformar a linguagem falada em vídeo com um intérprete virtual de linguagem de sinais. O algoritmo avalia de forma independente a qualidade do trabalho. A rede neural ajudará as pessoas com perda auditiva parcial ou total a melhorar a percepção do conteúdo e a se sentir mais à vontade em eventos públicos.

Existem dezenas de milhões de surdos e com deficiência auditiva no mundo que usam a linguagem de sinais como principal meio de comunicação. Por um lado, no mundo online, o problema de comunicação do deficiente auditivo é resolvido com o auxílio da legenda. Mas, por outro lado, agora os webinars, streams e outros conteúdos populares precisam ser traduzidos para a linguagem de sinais em tempo real. Os cientistas já pesquisam esse problema há muito tempo e procuram uma solução.

Os pesquisadores agora estão buscando a neurotecnologia. Na Universidade de Surrey, os desenvolvedores criaram um algoritmo de tradução de linguagem de sinais de nova geração. A IA converte a linguagem falada em movimentos do esqueleto humano. O esqueleto ganha uma aparência humana e uma filmagem realista é criada. Com a ajuda da tecnologia, você também pode produzir vídeos baseados em texto.

Por que essas dificuldades e por que o movimento de todo o esqueleto é importante? A linguagem de sinais não envolve apenas sinais de mão, envolve todas as partes do corpo e até mesmo as expressões faciais. As tecnologias anteriores geralmente geravam modelos vagos, o que levava à distorção de significados ou mesmo a mal-entendidos da fala do intérprete virtual de linguagem de sinais.

Foto: ru.freepik.com

Como funciona a nova rede neural

O algoritmo é baseado no seguinte: o sinal de recepção vem em forma de áudio, então é convertido em um modelo esquemático do esqueleto humano, que reproduz a fala com os gestos apropriados. A sequência de poses é então enviada ao U-Net. A web converte movimentos e poses em vídeos realistas.

Algoritmo de um intérprete virtual de linguagem de sinais

Para alcançar resultados elevados, os cientistas treinaram uma rede neural usando vídeos de intérpretes de linguagem de sinais reais.

Para avaliar o modelo resultante, os desenvolvedores realizaram experimentos com voluntários. Então, eles pediram que comparassem o novo método com outros métodos de transformação de fala usados anteriormente. Das 46 pessoas, 13 eram falantes de língua de sinais. A comparação foi realizada de acordo com quatro parâmetros, para cada um dos quais o novo algoritmo superou as versões anteriores em qualidade.

Resultados de um estudo com voluntários

Não apenas cientistas britânicos

Desde o início do século, os pesquisadores têm se desenvolvido na área de tradução em linguagem de sinais. Um dos produtos mais famosos é o tradutor virtual animado da IBM . Mas o projeto não foi desenvolvido. Vários anos depois, ele reencarnou em Novosibirsk. O programa , inventado por cientistas do Novosibirsk Academgorodok, reconhece a fala, analisa o significado e se traduz em linguagem de sinais. Em seguida, o avatar mostra o texto na tela.

Tradutor animado de linguagem de sinais de desenvolvedores de Novosibirsk

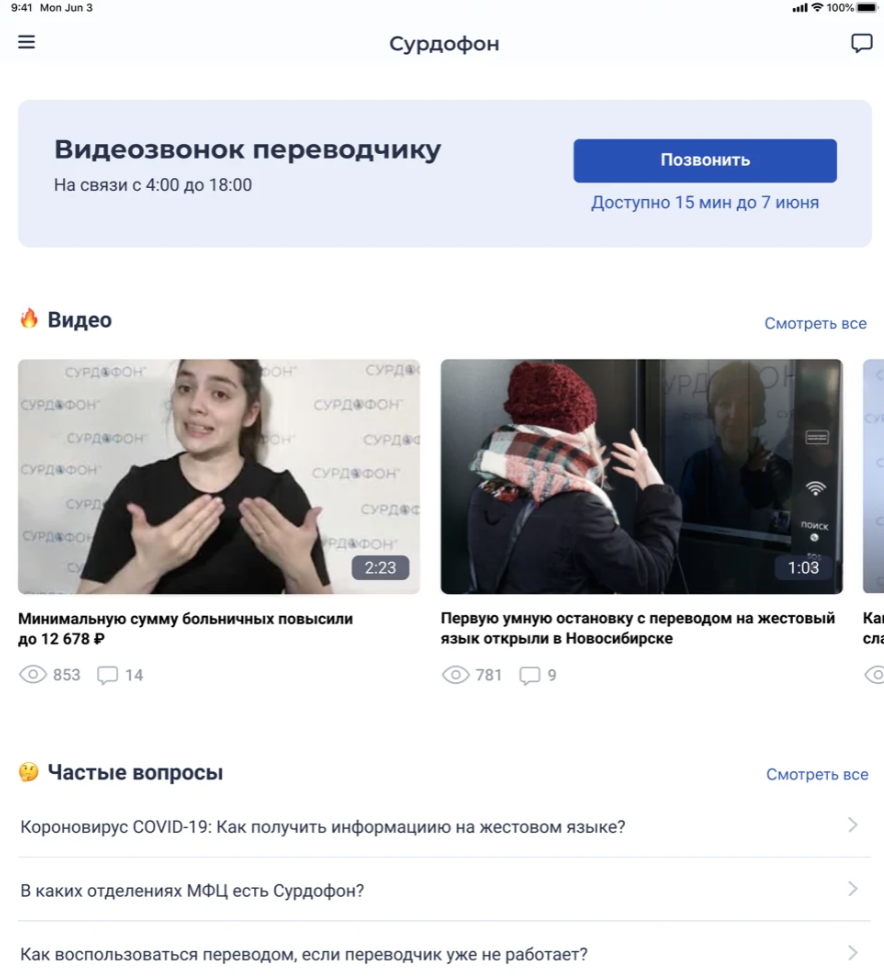

Naquela época, acreditava-se que o desenvolvimento se tornaria tão popular quanto o Google Translator. Agora você pode testar o programa no aplicativo Adaptis para AppStore e Google Play .

Captura de tela do aplicativo Adaptis na App Store

Alguns anos atrás, cientistas belgas imprimiram uma mão 3D controlada por Arduino que também funciona como intérprete de linguagem de sinais. O projeto foi denominado ASLAN. O braço consistia em 25 peças PLA separadas. No futuro, eles pretendiam adicionar outra mão e um rosto robótico para transmitir emoções.

A tradução da língua de sinais para a língua a que estamos habituados também apresenta grandes dificuldades. Cientistas russos do Institute for Management Problems. V.A. O Instituto Trapeznikov de Ciências de Controle da Academia Russa de Ciências (IPU RAS), há alguns anos, começou o desenvolvimento de tal IA. No futuro, ele deveria ajudar a traduzir gestos em palavras, frases e letras. Os cientistas relataram então que pode levar mais de um ano para criar um algoritmo.

Foto: ru.freepik.com O

programa russo será baseado em um site criado por um funcionário com deficiência auditiva do Instituto de Ciências de Controle da Academia Russa de Ciências. Ela tem desenvolvido o site Surdoserver há vários anos. Ao mesmo tempo, foi relatado que cientistas russos estão trabalhando em um aplicativo móvel "Surdoservice" e uma nuvem surda para a troca de informações por pessoas com deficiência auditiva.