Nos últimos anos, avanços significativos foram feitos no campo do processamento de linguagem natural (PNL) , onde modelos como BERT , ALBERT , ELECTRA e XLNet alcançaram uma precisão impressionante em várias tarefas. Durante o pré-treinamento , as representações vetoriais são formadas com base em um extenso corpus de textos (por exemplo, Wikipedia ), que são obtidos mascarando palavras e tentando predizê-las (a chamada modelagem de linguagem mascarada) As representações resultantes codificam uma grande quantidade de informações sobre a linguagem e a relação entre conceitos, por exemplo, entre um cirurgião e um bisturi. Em seguida, começa a segunda etapa do treinamento - ajuste fino - em que o modelo usa dados aprimorados para uma tarefa específica, a fim de aprender a realizar tarefas específicas como classificação usando representações pré-treinadas gerais . Dado o uso generalizado de tais modelos em vários problemas de PNL, é fundamental entender quais informações eles contêm e como quaisquer relacionamentos aprendidos afetam os resultados do modelo em suas aplicações, a fim de garantir que cumpram os Princípios de Inteligência Artificial (IA) .

O artigo “ Medindo correlações de gênero em modelos de PNL pré-treinados ” explora o modelo BERT e seu primo leve ALBERT em busca de relações de gênero e formula uma série de melhores práticas para o uso de modelos de linguagem pré-treinados. Os autores apresentam resultados experimentais na forma de pesos de modelos públicos e conjuntos de dados exploratórios para demonstrar a aplicação das melhores práticas e fornecer uma base para uma investigação mais aprofundada dos parâmetros, o que está além do escopo deste artigo. Além disso, os autores planejam estabelecer um conjunto de pesos Zari , no qual o número de correlações de gênero é reduzido, mas a qualidade é mantida alta em problemas padrão de PNL.

Medindo correlações

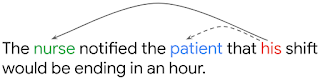

, , , . , . , , his («») nurse ( «»), patient («»).

– OntoNotes (Hovy et al., 2006). F1-, ( Tenney et al. 2019). OntoNotes , WinoGender, , , . ( 1) WinoGender , (.. nurse , ). , , , - , .

BERT ALBERT OntoNotes () WinoGender ( ). WinoGender , , .

, (Large) BERT, ALBERT WinoGender, ( 100%) (accuracy) OntoNotes. , . : , . , .. , , , , .

: NLP- ?

- : , , , . , BERT ALBERT 1% , 26% . : , WinoGender , , , , , , (male nurse).

- : , . , , , , . , , - (dropout regularization), : (dropout rate) BERT ALBERT, . , , , .

- : : , , WinoGender - . , OntoNotes ( BERT'), , - , . (. ).

, NLP-, . , . , , , , . , , , .

- — Kellie Webster

- Tradução - Ekaterina Smirnova

- Edição e layout - Sergey Shkarin